https://friendsofscience.org/pages/essay.html

Essai scientifique sur le changement climatique

par Ken Gregory

INTRODUCTION

L'un des objectifs de la Friends of Science Society

est d'éduquer le public sur la science du climat et les mérites scientifiques

de l'hypothèse du réchauffement climatique induit par l'homme. La science

du changement climatique est complexe. Malheureusement, la politique et

les médias ont infecté la science. Les instituts de recherche sur le

climat savent qu'ils doivent présenter des prévisions climatiques effrayantes

pour recevoir un financement continu - pas de crise, signifie, pas de

financement. Les médias présentent des histoires de catastrophe climatique

pour vendre leurs produits. La recherche scientifique qui suggère que le changement climatique est

principalement naturel ne reçoit pas beaucoup de couverture médiatique, voire

aucune. Ces facteurs ont amené le grand public à être sérieusement induit

en erreur sur les questions climatiques, ce qui a entraîné des dépenses

inutiles de milliards de dollars dans une tentative inefficace de contrôler le

climat.

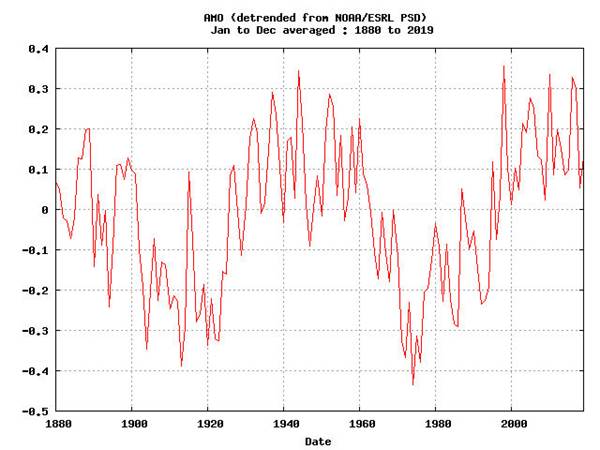

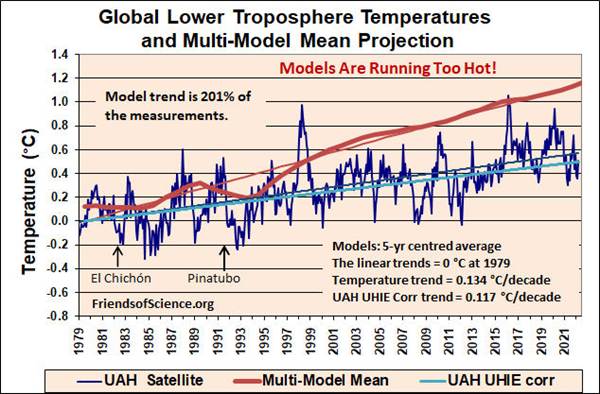

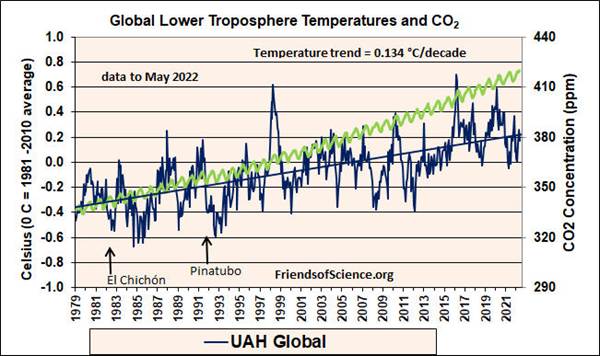

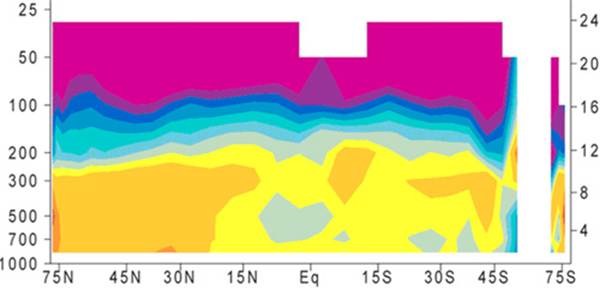

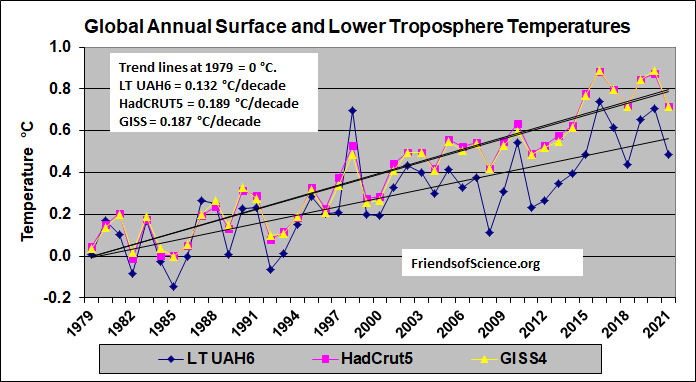

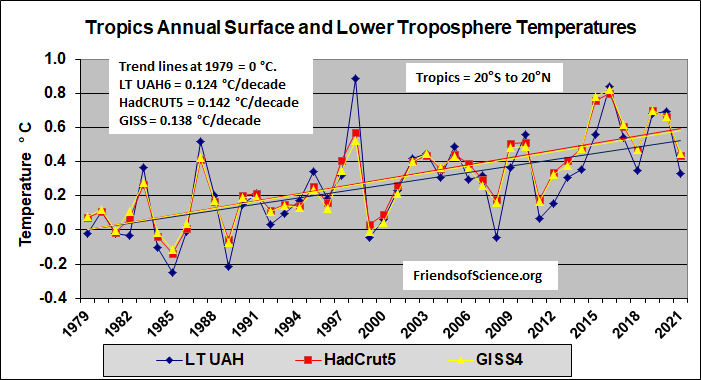

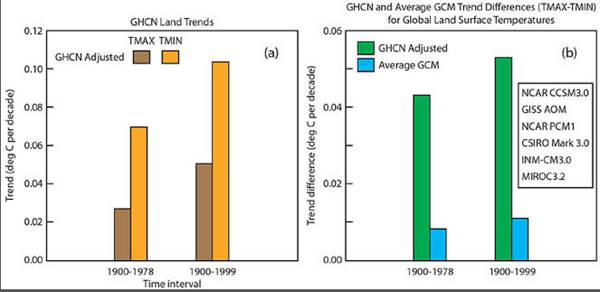

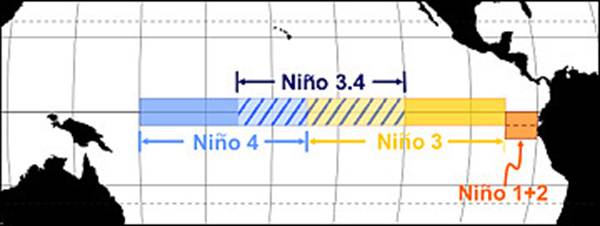

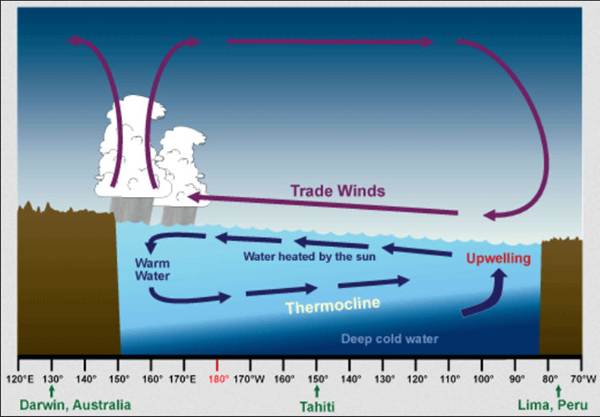

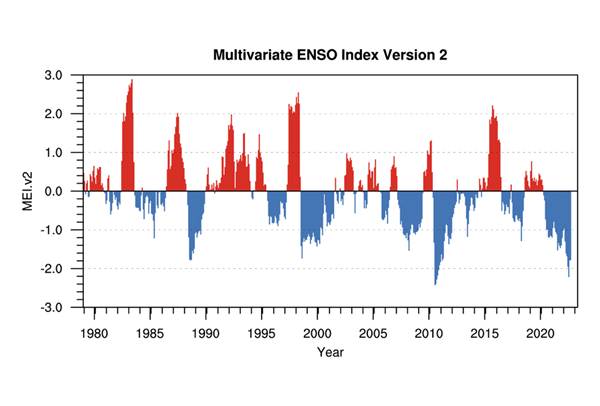

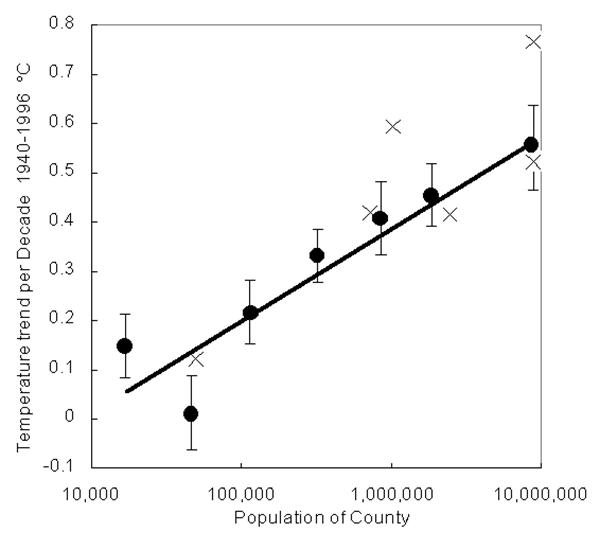

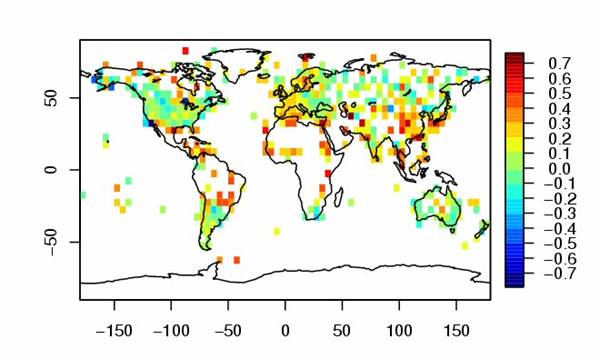

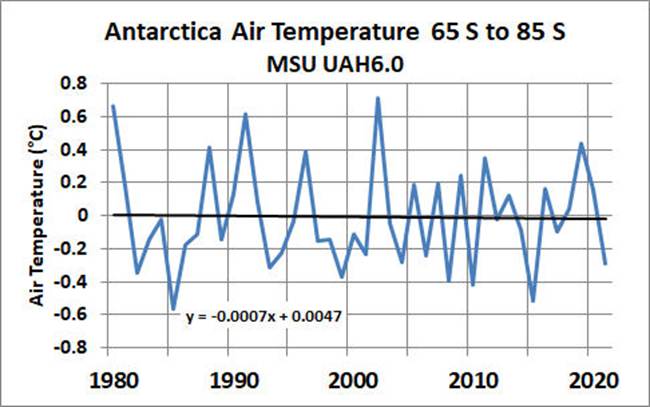

Le graphique ci-dessus montre les changements de température [MT1] de la basse troposphère depuis la surface

jusqu'à environ 8 km, tels que déterminés par les données

satellitaires de l'Université de l'Alabama à Huntsville (UAH) . La ligne de meilleur

ajustement (bleu foncé) de janvier 1979 à septembre 2022 indique une tendance

de 0,134 °Celsius/décennie. Les fortes pointes de température de 1998,

2010 et 2016 sont des événements El Niño. Les données de température de surface sont contaminées

par les effets du développement urbain. L'activité du Soleil, qui a

augmenté pendant la majeure partie du 20siècle, est récemment devenu

calme. Le flux magnétique du Soleil a atteint un pic en 1991. Le flux

magnétique élevé réduit la couverture nuageuse et provoque un

réchauffement. Depuis lors, le Soleil s'est calmé, mais il continue de

provoquer un réchauffement pendant quelques décennies après son pic d'intensité

en raison de l'énorme capacité calorifique des océans. Les données sont obtenues à partir d'unités

de sondage micro-ondes (MSU) sur les satellites de la National Oceanic and Atmospheric

Administration, qui relient l'intensité ou la luminosité des micro-ondes émises

par les molécules d'oxygène dans l'atmosphère à la température. L'ensemble

de données MSU représente les températures d'une couche de l'atmosphère qui

s'étend de la surface à environ 8 kilomètres (5 miles) au-dessus de la

surface. La ligne rouge foncé est la moyenne centrée sur 5 ans de la basse

troposphère des modèles climatiques. La tendance du modèle est de 201% des mesures. La

ligne UAH UHIE corr (bleu clair) est la tendance

corrigée de l'effet d'îlot de chaleur urbain basée sur cette étude qui donne une correction de -0,017

°C/décade.

La science en résumé

L'histoire de la Terre nous apprend que le climat

change constamment; des périodes chaudes où les

dinosaures ont prospéré, aux nombreuses périodes glaciaires où les glaciers

couvraient une grande partie de la terre. Le climat a toujours changé en

raison des cycles naturels sans aucune aide humaine.

Le Groupe d'experts intergouvernemental sur l'évolution du climat

(GIEC) des Nations Unies est une organisation politique qui promeut une théorie

selon laquelle les récentes augmentations mineures de température pourraient

être causées en grande partie par les émissions de dioxyde de carbone (CO 2) d'origine humaine. Le CO 2 est un gaz infrarouge, et des

concentrations croissantes peuvent potentiellement augmenter la température

globale moyenne car le gaz absorbe le rayonnement à ondes longues de la Terre

et réémet l'énergie absorbée. Cependant, la capacité de réchauffement du

CO2 est limité car

une grande partie du spectre d'absorption est presque saturée. Lorsque les concentrations de CO2 étaient

dix fois plus élevées qu'aujourd'hui, la Terre était aux prises avec l'une des

périodes glaciaires les plus froides. Le système climatique est dominé

par de fortes rétroactions négatives des nuages et de la vapeur

d'eau qui compensent les effets de réchauffement des émissions de CO2.

L'histoire du climat et de

la concentration de CO2 montre

que les changements de température précèdent les changements de CO2 et

ne peut pas être un moteur majeur du climat. Les changements de température sur

différentes échelles de temps ont été bien corrélés aux cycles solaires, au

flux de rayons cosmiques et à la couverture nuageuse. Des recherches récentes montrent

que les rayons cosmiques agissent comme un catalyseur pour créer des nuages

bas, qui refroidissent la planète. Lorsque le

Soleil est plus actif, le vent solaire repousse les rayons cosmiques, réduisant

la couverture nuageuse basse permettant au Soleil de réchauffer la planète.

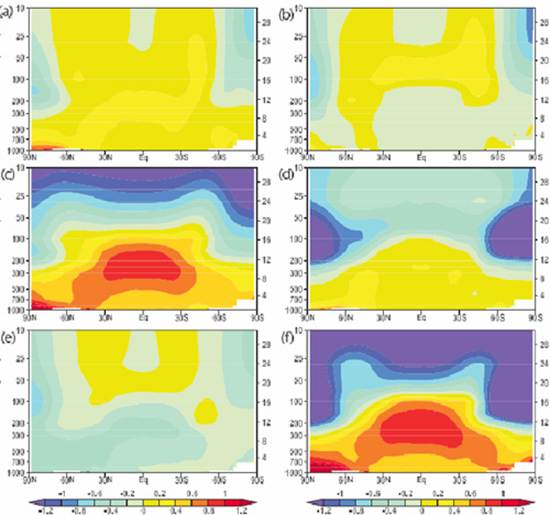

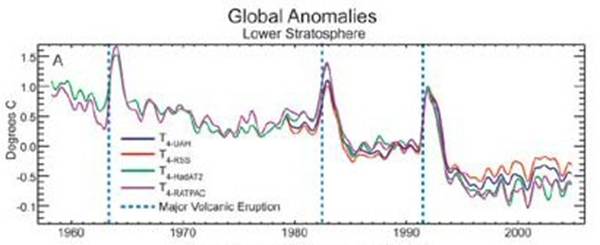

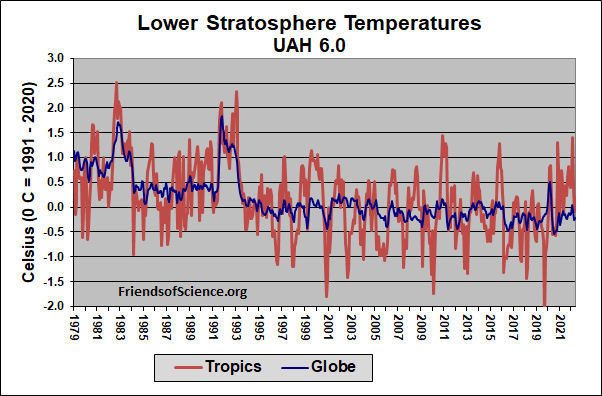

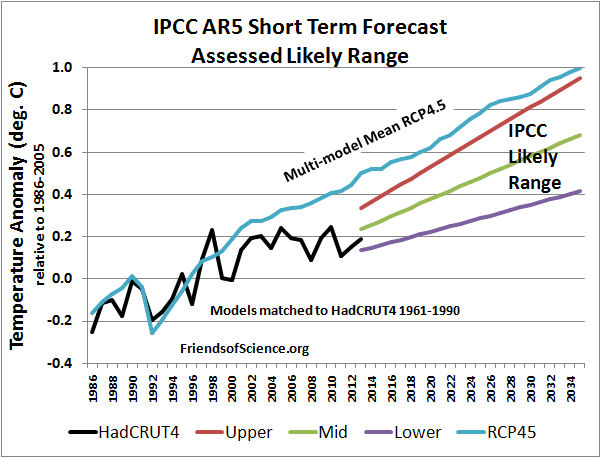

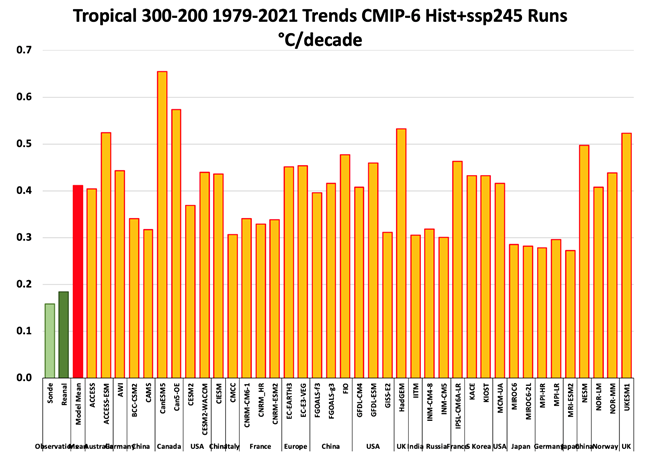

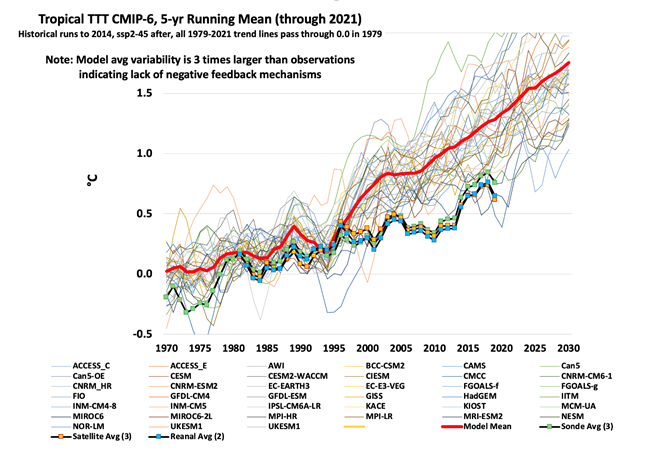

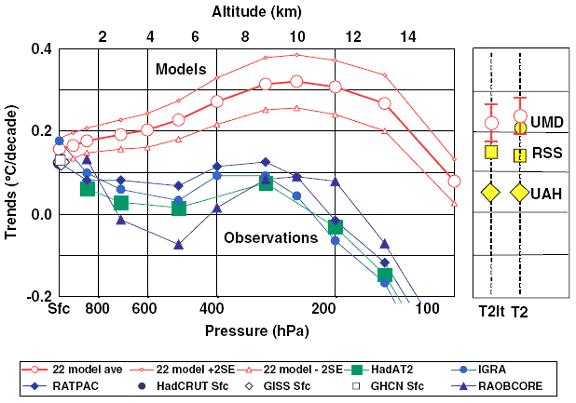

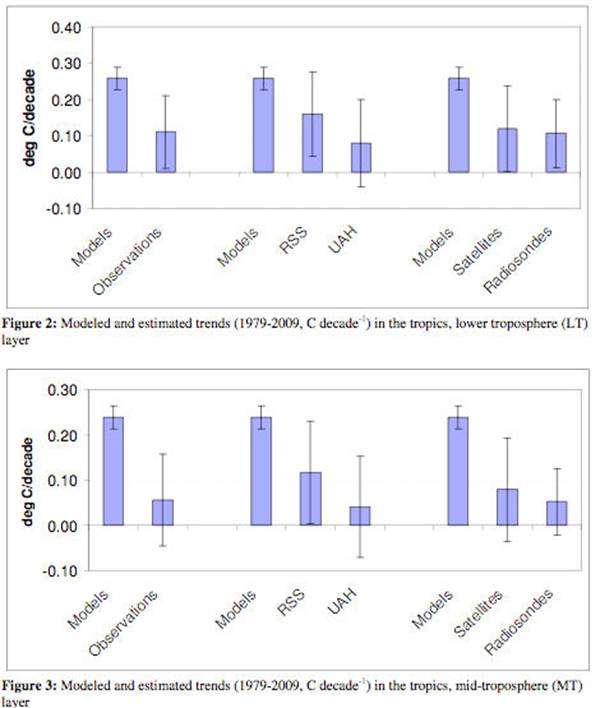

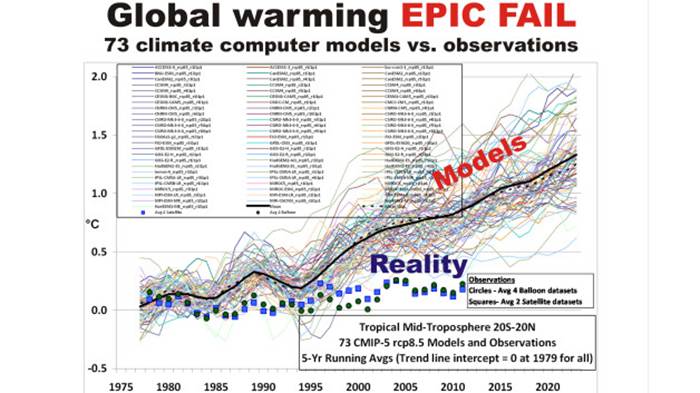

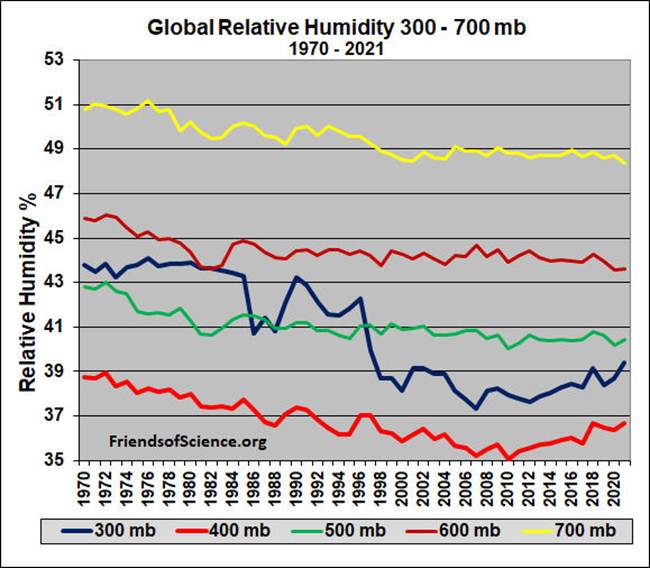

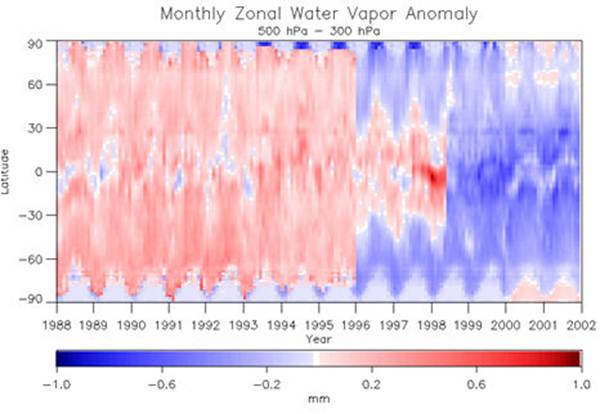

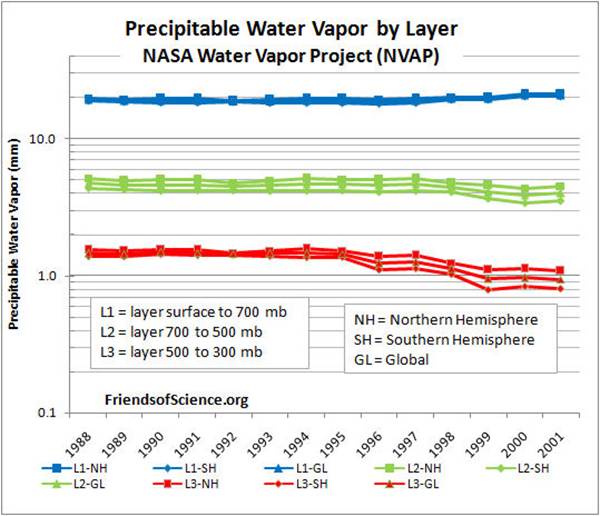

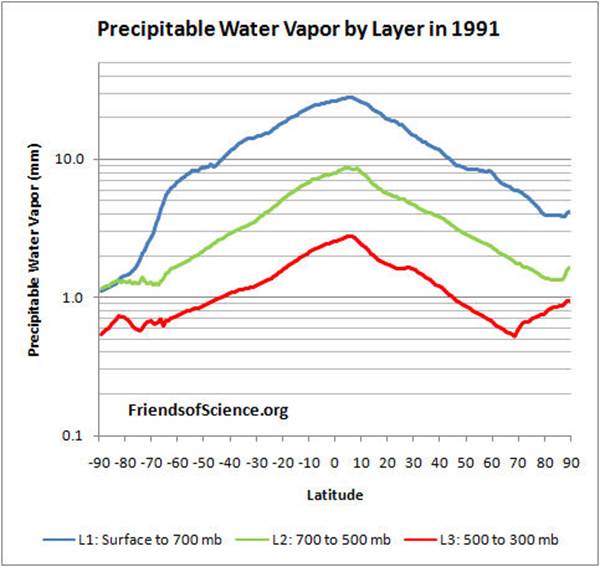

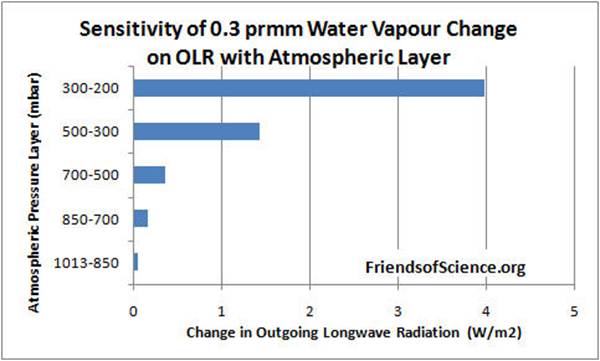

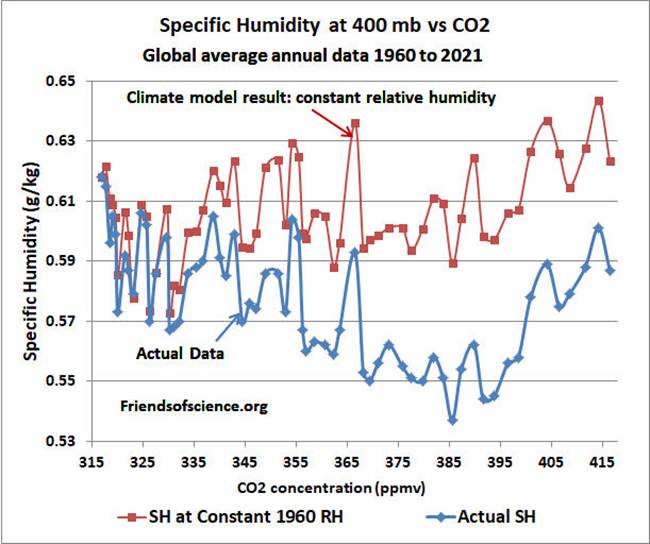

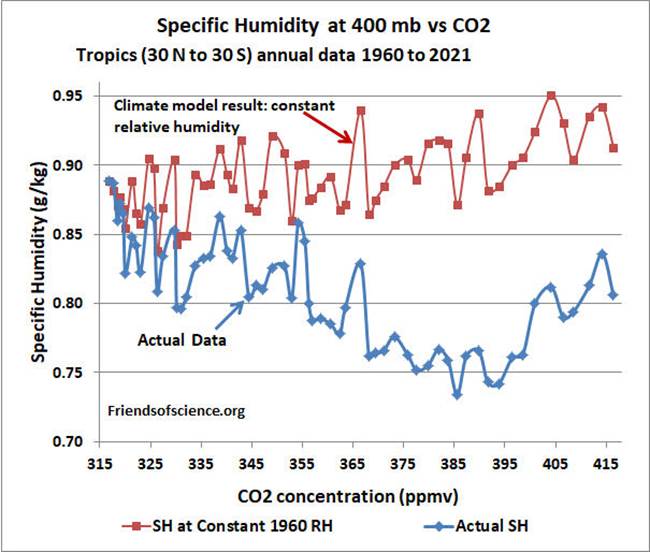

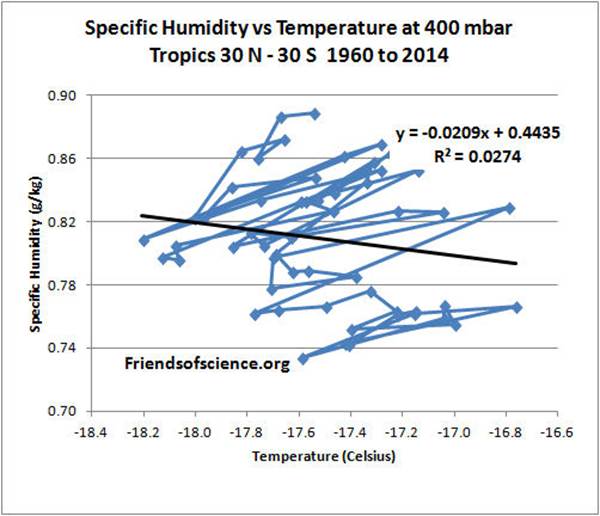

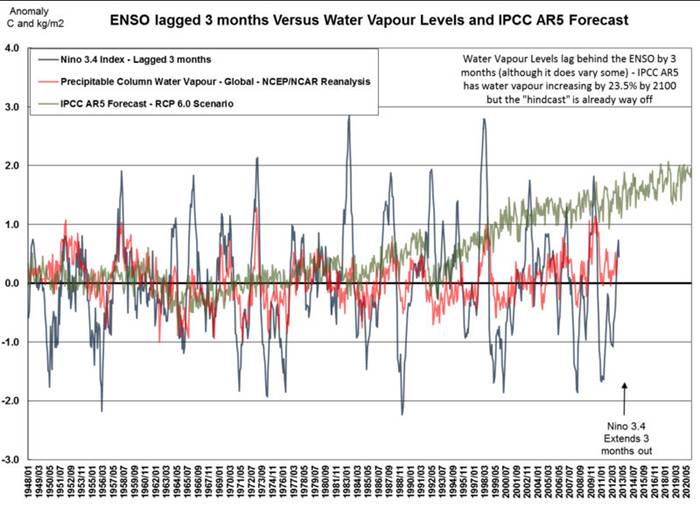

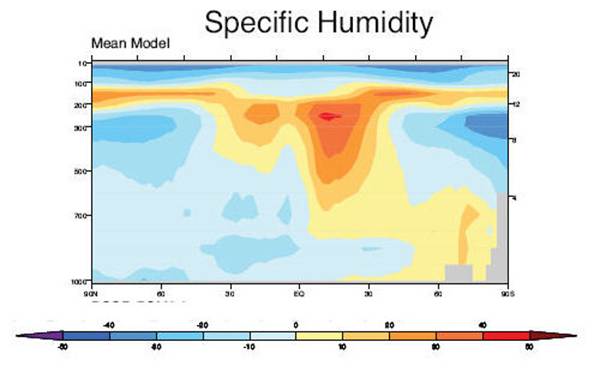

Les résultats des modèles informatiques présentés dans le

cinquième rapport d'évaluation du GIEC prédisent que le réchauffement

climatique entraînera un profil de température distinctif dans l'atmosphère

avec un taux de réchauffement accru dans la haute atmosphère à une altitude de

8 à 12 km au-dessus des tropiques. Le profil de température prévu est le

résultat d'une augmentation attendue de la vapeur d'eau dans la haute

atmosphère qui triplerait le réchauffement CO2 induit. Les modèles

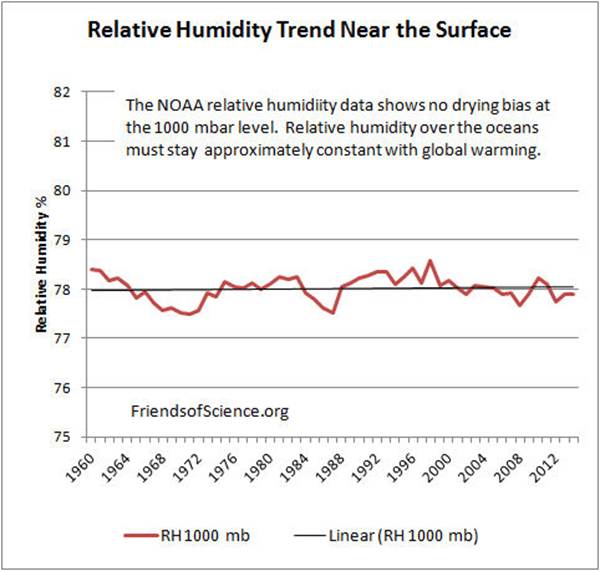

informatiques sont programmés pour prévoir une humidité relative constante de

la vapeur d'eau avec l'augmentation du CO2 résultant en une importante

rétroaction de la vapeur d'eau. Les données de température réelles ne montrent pas un

telle amplification du réchauffement profil. Par conséquent, la

comparaison des données observées aux résultats des modèles informatiques

prouve qu'aucune amplification du réchauffement induite par la vapeur d'eau

n'existe, de sorte que le CO2 n'est

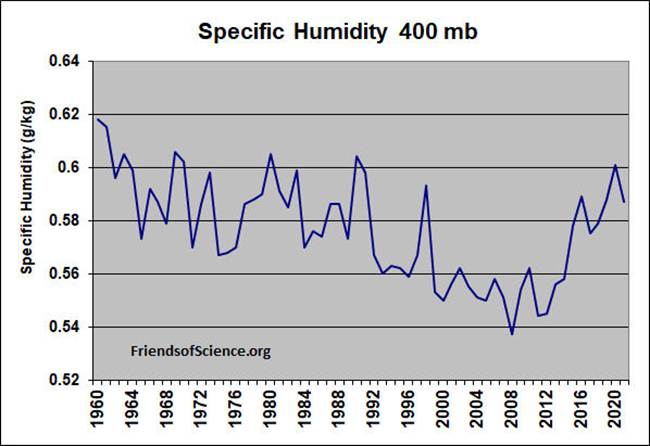

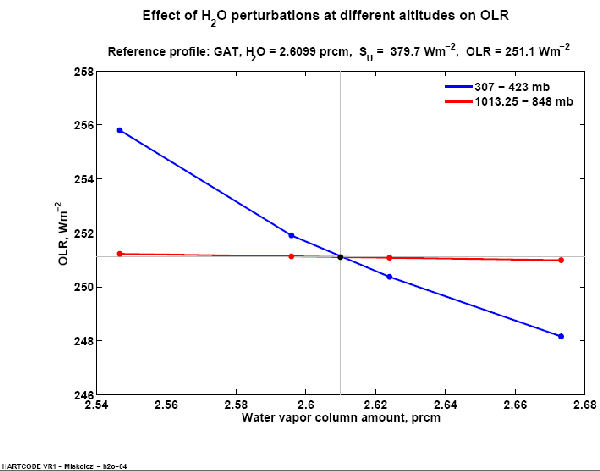

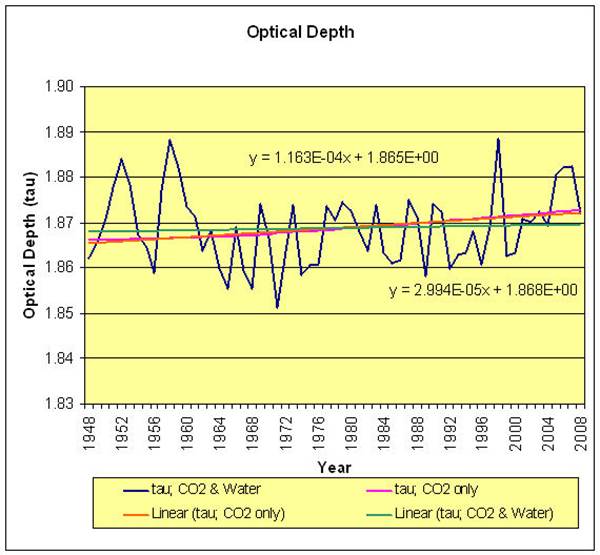

pas le principal facteur climatique. Dans les couches d'atmosphère

proches de 8 km, la tendance de température modélisée à partir de 1980 est de

2000 à 400 % supérieure à celle observée. Les données des ballons

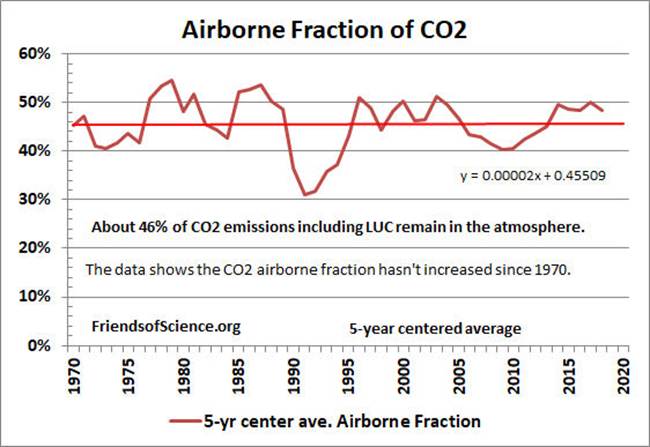

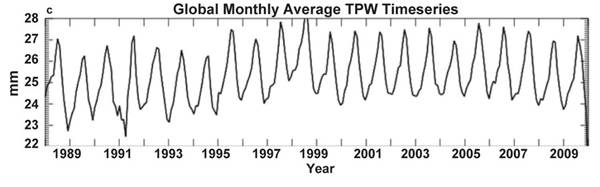

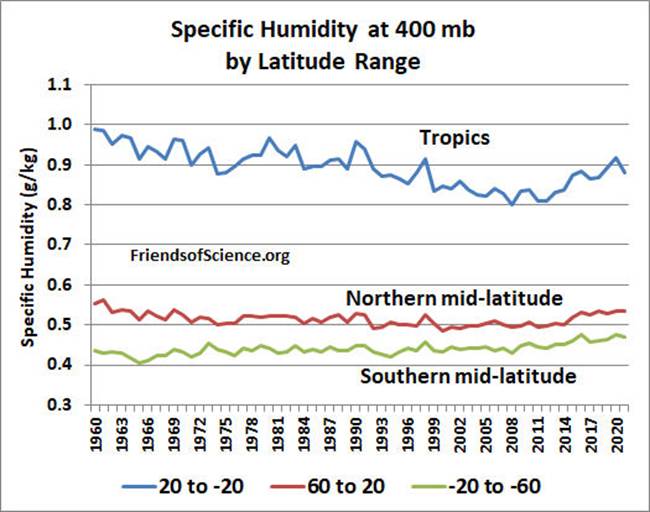

météorologiques montrent que l'humidité spécifique a chuté de 9% depuis 1960

dans la haute troposphère (niveau de pression de 400 mbar) où les modèles

prédisent la plus grande rétroaction. L’ajout de CO²à l'atmosphère peut

réduire la vapeur d'eau de la haute atmosphère, le gaz à effet de serre le plus

important, ce qui n'entraîne qu'une faible augmentation de l'effet de serre.

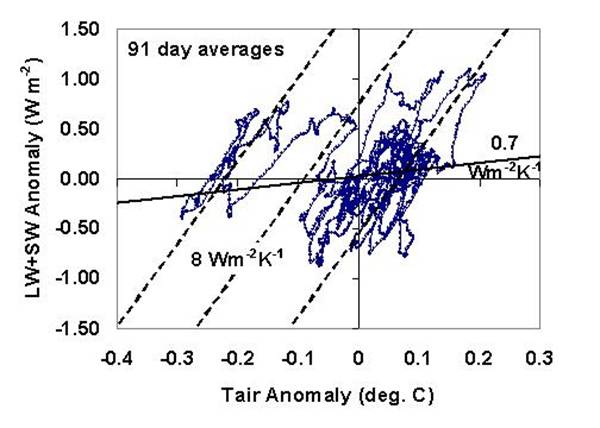

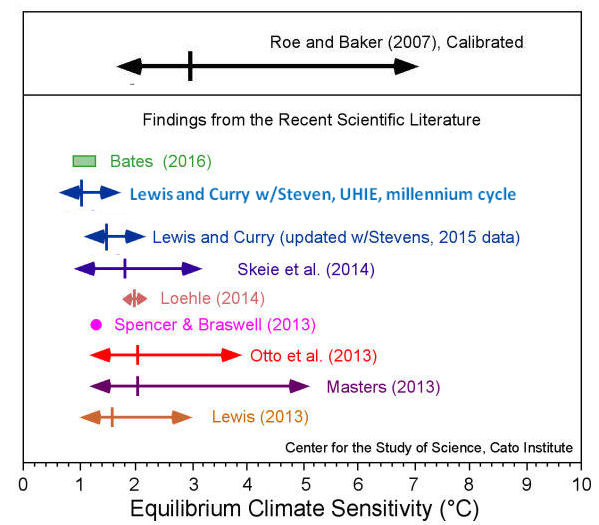

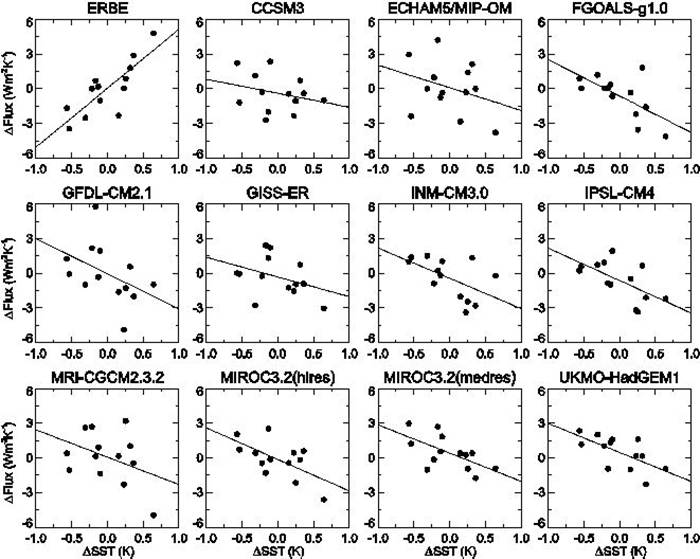

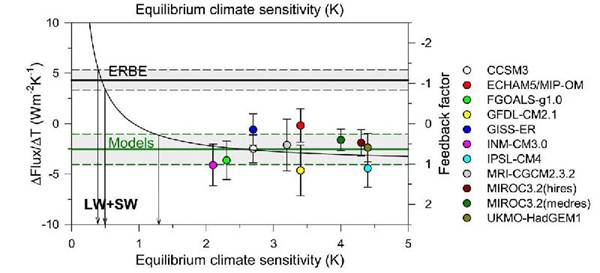

Une analyse des données

satellitaires montre que les nuages provoquent une forte

rétroaction négative sur la température, mais les modèles climatiques supposent

que les nuages provoquent une rétroaction positive. Les modélisateurs ont supposé que tous les changements de

nuages sont causés par des changements

de température, ce qui leur permet de déduire une rétroaction

positive. Mais l'évolution de la couverture nuageuse peut également

entraîner des changements de température. Les scientifiques peuvent

maintenant séparer ces deux effets. L'analyse correcte montre que les nuages

provoquent une forte rétroaction négative, donc si les

températures augmentent, la couverture nuageuse augmente, renvoyant l'énergie

solaire vers l'espace et réduisant considérablement l'effet de réchauffement

des émissions de CO2.

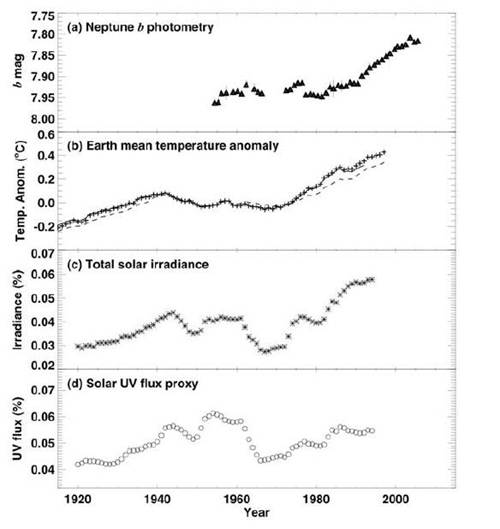

Plusieurs planètes et lunes se sont réchauffées récemment avec la

Terre, confirmant une tendance naturelle au réchauffement causée par le

soleil. Sur des

périodes plus longues, à mesure que le système solaire entre et sort des bras

galactiques, le flux de rayons cosmiques change, provoquant des périodes

glaciaires et des périodes chaudes. Une comparaison des données

indirectes sur la température et l'activité solaire suggère que les effets

solaires peuvent expliquer au moins 75 % du réchauffement de la surface au

cours des 100 dernières années.

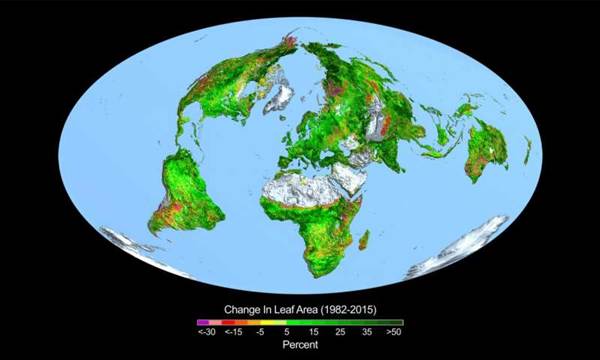

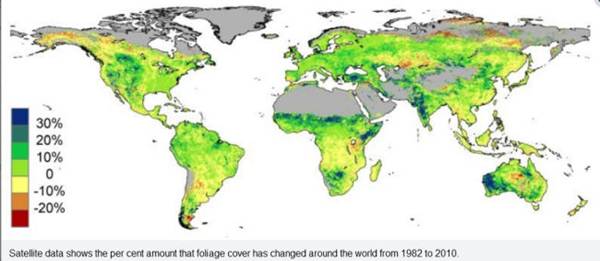

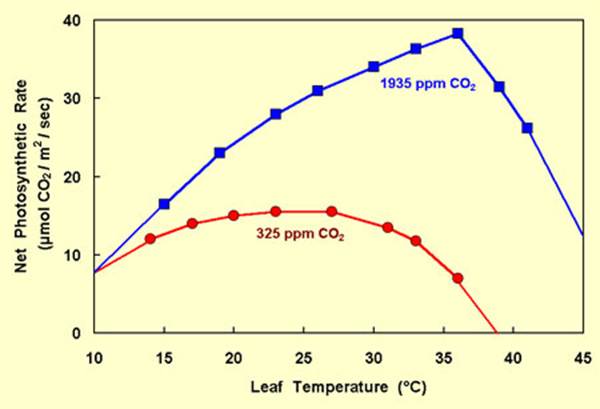

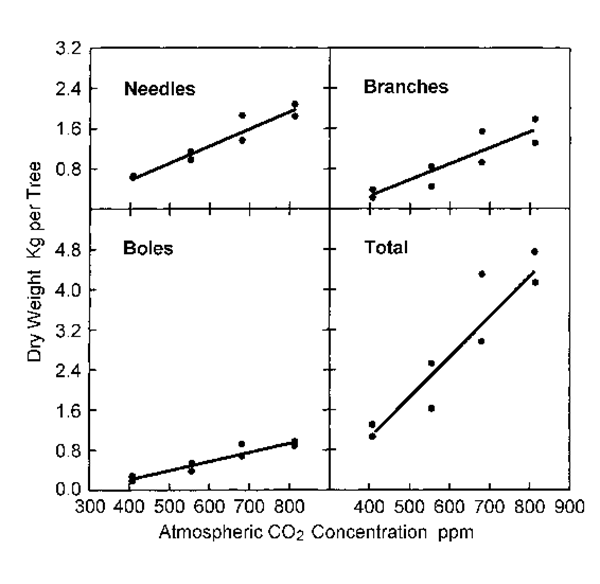

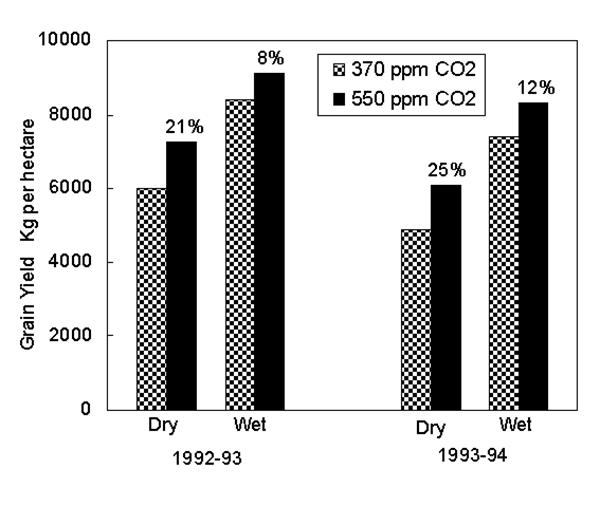

Le CO 2 est un aliment végétal et

l'augmentation de la concentration de CO2 a

peut-être augmenté la production alimentaire mondiale de 15 % depuis 1950, ce

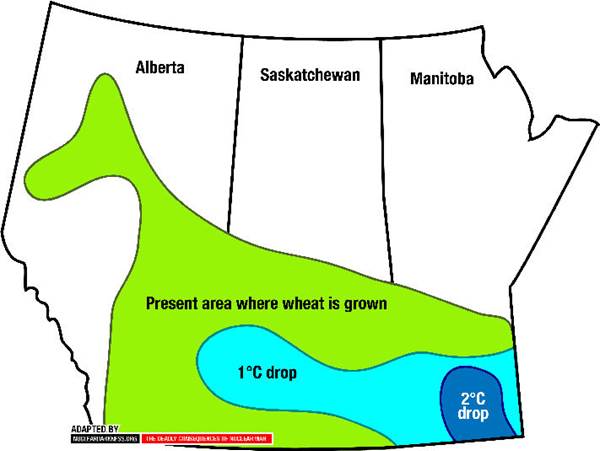

qui a entraîné d'énormes avantages pour les personnes. Pour le Canada, tout effet de

réchauffement du CO2 nous profiterait également en

réduisant nos coûts de chauffage des locaux et en rendant le climat plus

agréable.

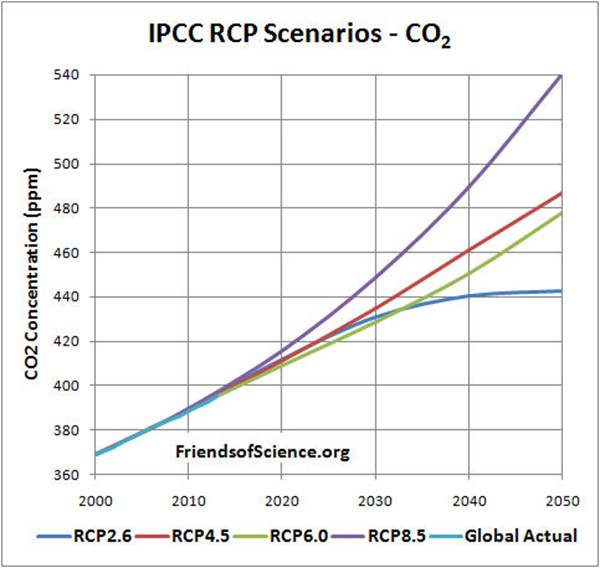

Le GIEC prévoit que les températures moyennes mondiales

augmenteront de 0,17 à 0,38 °C par décennie jusqu'à la fin du siècle en

fonction du taux de croissance du CO 2 dans l'atmosphère et d'autres

hypothèses. Les projections supposent qu'aucune mesure n'est prise pour

limiter les émissions de CO2. Cependant, ces prédictions sont irréalistes car elles

supposent à tort que les récents changements de température sont uniquement dus

au CO2 et

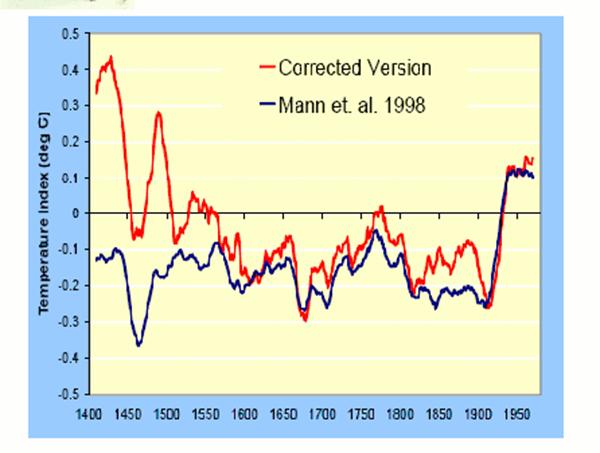

que le Soleil a peu d'effet sur le climat. Une étude récente des changements

climatiques passés utilisée par le GIEC s'est avérée erronée en raison de

l'utilisation d'un algorithme défectueux et d'une sélection inappropriée des

données.

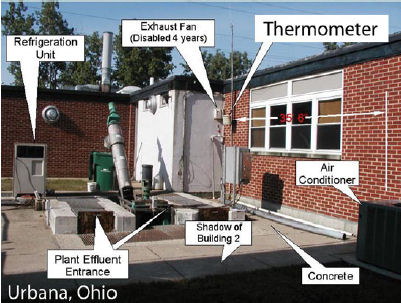

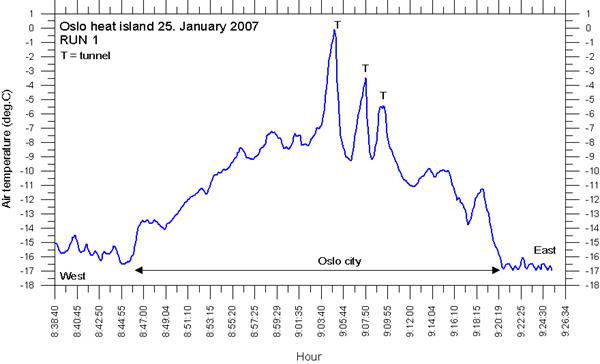

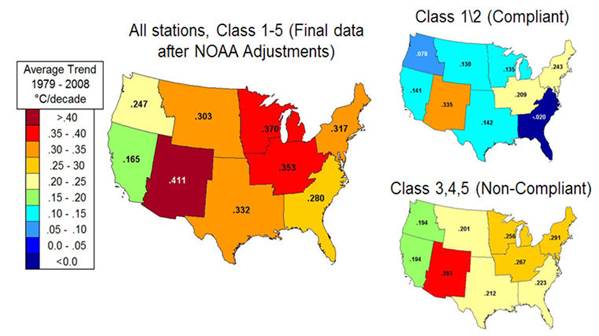

Le record de température

terrestre est contaminé par l'effet d'îlot de chaleur urbain. Corriger

complètement le record de température terrestre réduirait de moitié la tendance

au réchauffement de 1980 à 2002. L'enregistrement

historique du CO 2 du GIEC peut être incorrect en

raison d'ajustements inappropriés des données des carottes de glace et de

l'ignorance des mesures historiques directes du CO2. Le GIEC sélectionne et ajuste les

données pour se conformer à son hypothèse de réchauffement du CO2 et ignore les théories climatiques

alternatives. C'est la mauvaise façon de faire de la science. De nombreux scientifiques sont

fortement en désaccord avec les conclusions du GIEC.

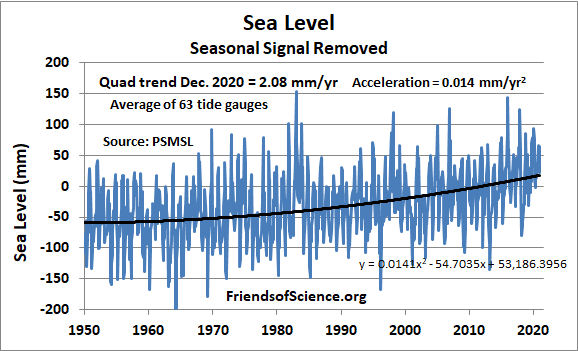

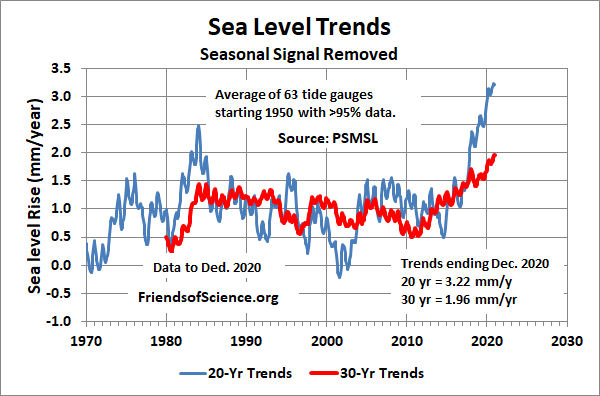

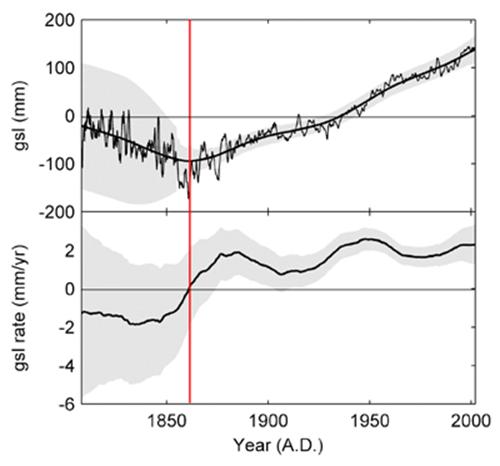

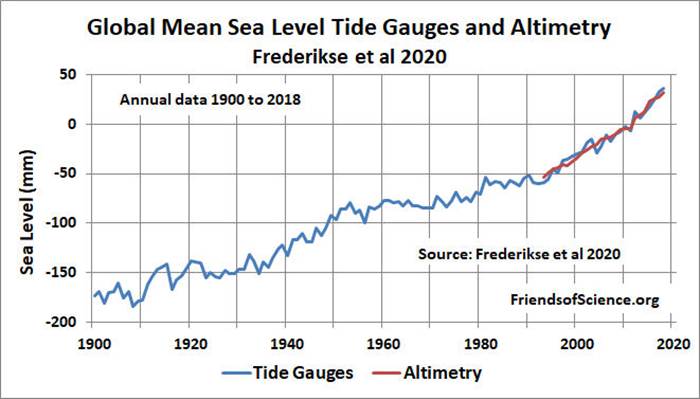

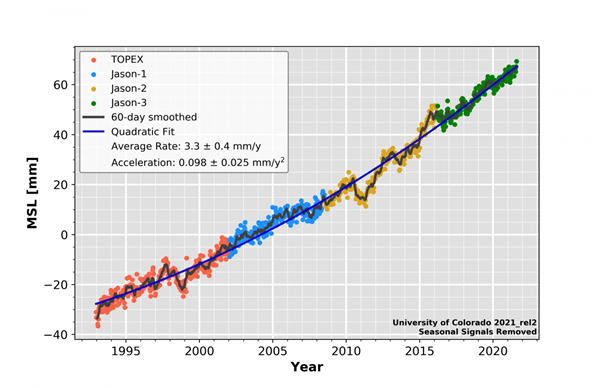

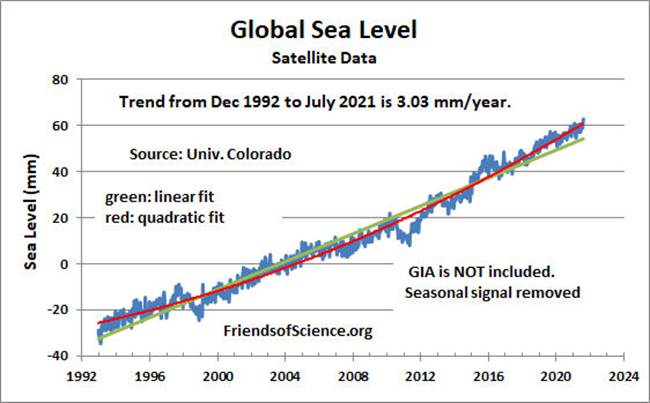

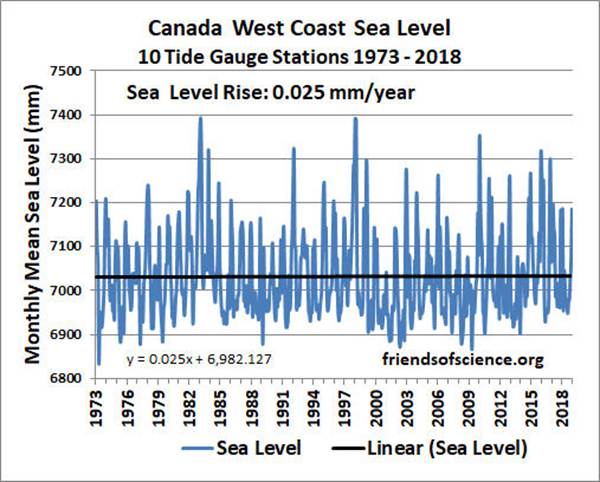

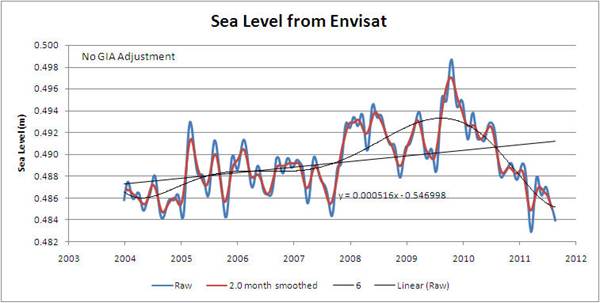

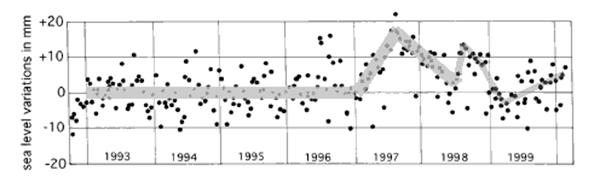

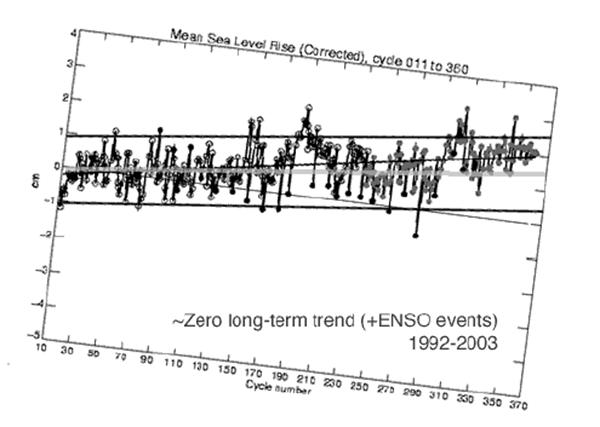

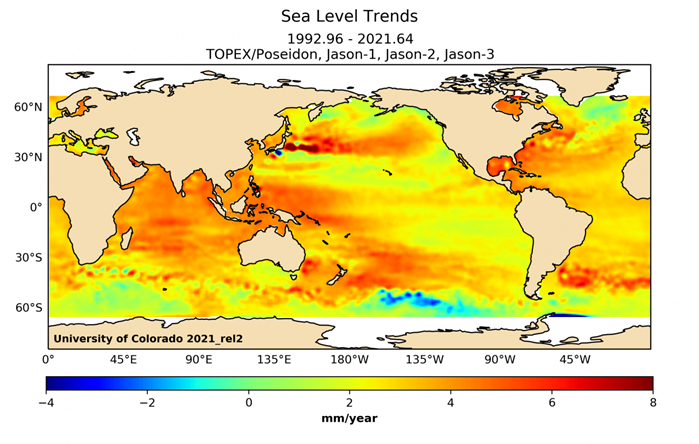

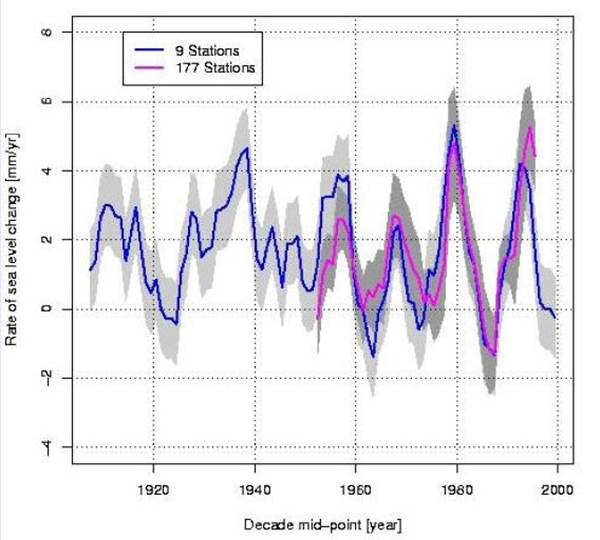

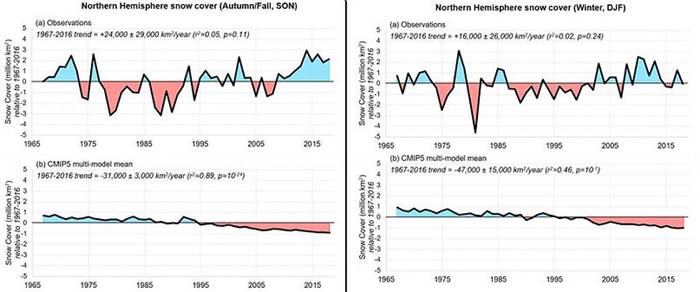

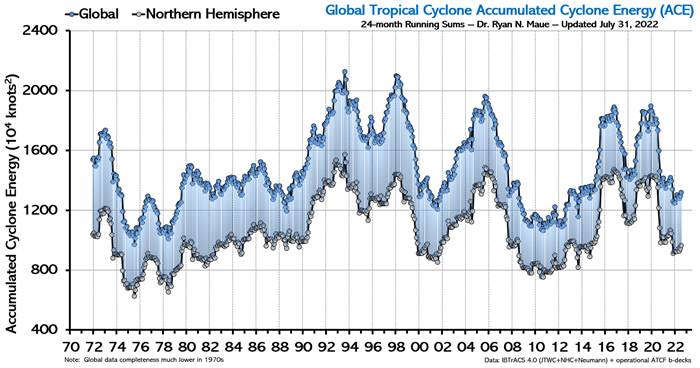

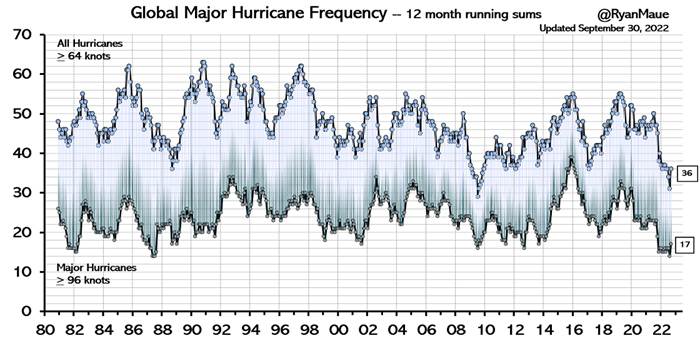

Les données sur le niveau de la mer ne montrent aucune

augmentation du taux récent d'élévation du niveau de la mer, et aucune

augmentation de ce type n'est attendue au cours des cent prochaines

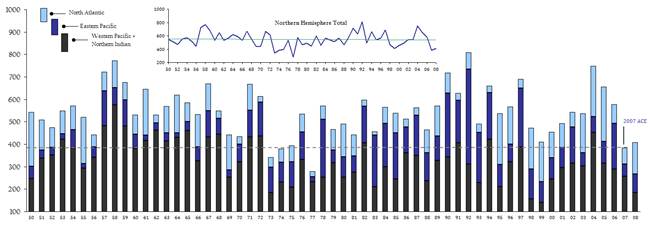

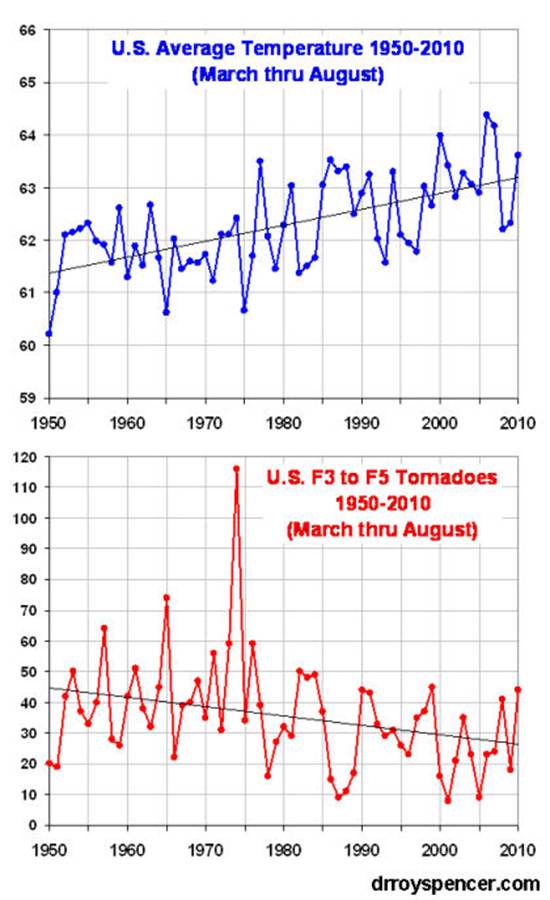

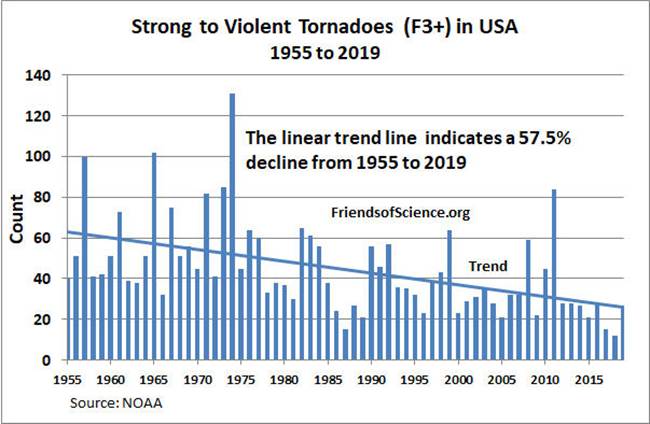

années. Il n'y a pas eu d'augmentation détectée des tempêtes violentes et

il n'y a aucune raison de s'attendre à une augmentation du nombre ou de

l'intensité des ouragans résultant d'un réchauffement supposé être dû aux

émissions de CO2 d'origine humaine

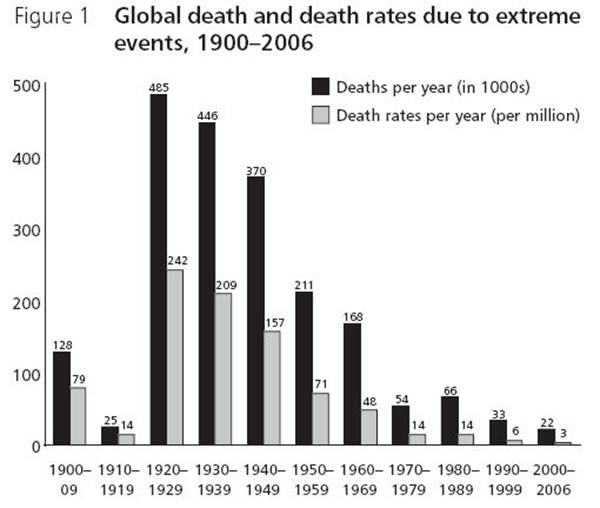

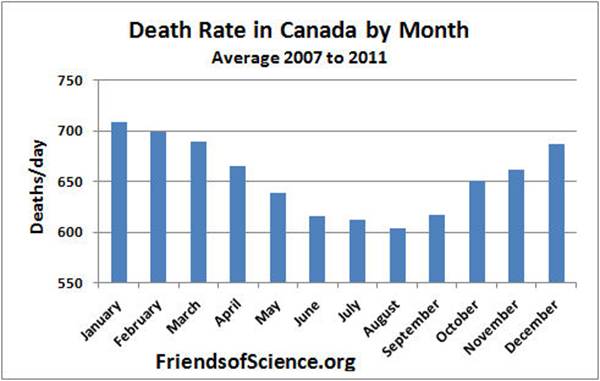

Toute augmentation des températures due aux émissions de CO2 d'origine humaine sera probablement

bénéfique pour la santé humaine. L'effet de fertilisation du CO2 augmentera le taux de croissance des

forêts et les augmentations de rendement des cultures induites par le CO2 réduiront les pressions pour abattre

les forêts pour l'expansion des terres agricoles. Cela profitera

grandement aux animaux en ralentissant la destruction de l'habitat.

Les avantages des émissions

du CO2 dépassent

largement tous les effets nocifs probables. Plusieurs autorités qui ont étudié

les cycles solaires ont averti que la Terre pourrait bientôt entrer dans une

phase de refroidissement car le Soleil devrait devenir moins

actif. L'atmosphère peut se réchauffer à cause de l'activité humaine, mais

si c'est le cas, le changement attendu ne devrait pas dépasser 0,8 °C, et

probablement moins, au cours des 100 prochaines années.

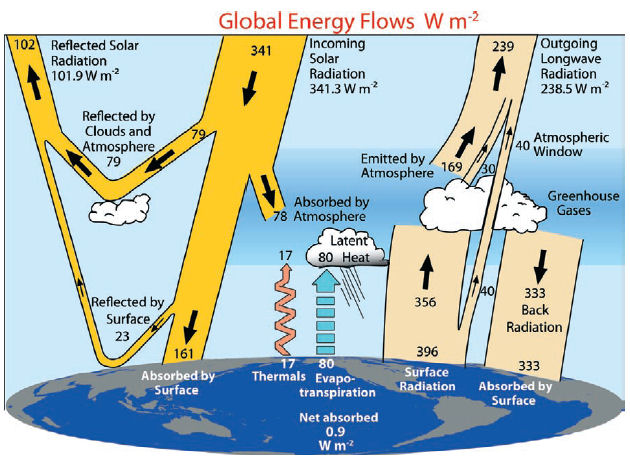

Ce graphique, de Trenberth et al 2009, illustre l'échange

d'énergie entre l'espace, le Soleil, l'atmosphère et la Terre.

Les gaz à effet de serre sont principalement la vapeur

d'eau, le dioxyde de carbone et l'ozone. Les gaz à effet de serre sont

pour la plupart transparents au rayonnement solaire entrant, mais absorbent le

rayonnement sortant à grande longueur d'onde. L'énergie absorbée est

ensuite transférée à des molécules plus froides ou rayonnée à des longueurs

d'onde plus longues que l'énergie précédemment absorbée. Ce processus rend

la Terre plus chaude qu'elle ne le serait autrement sans les gaz à effet de

serre (mais avec l'atmosphère et les nuages) d'environ 33 degrés Celsius.

[MT3]

La vapeur d'eau et les nuages représentent ensemble

plus de 70 % de l'effet de serre total actuel[MT4] . Cependant, en termes de

modifications de l'effet de serre dues aux activités humaines, la vapeur d'eau

est généralement considérée comme une rétroaction et non comme un agent de

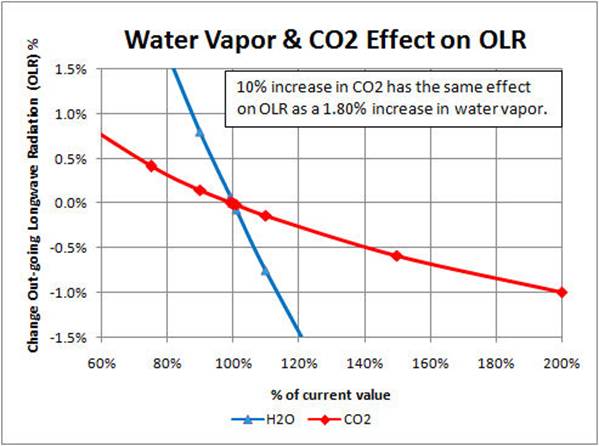

forçage. Des simulations informatiques montrent qu'un changement uniforme

de 1,8 % de la vapeur d'eau a le même effet sur le rayonnement à ondes longues

sortant qu'un changement de 10 % de la concentration de CO2.

Plus de gaz à effet de serre réduisent la transparence de

l'atmosphère au rayonnement à ondes longues de la surface.

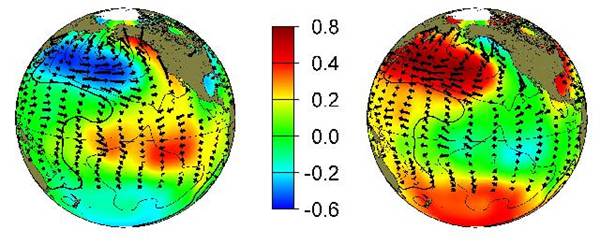

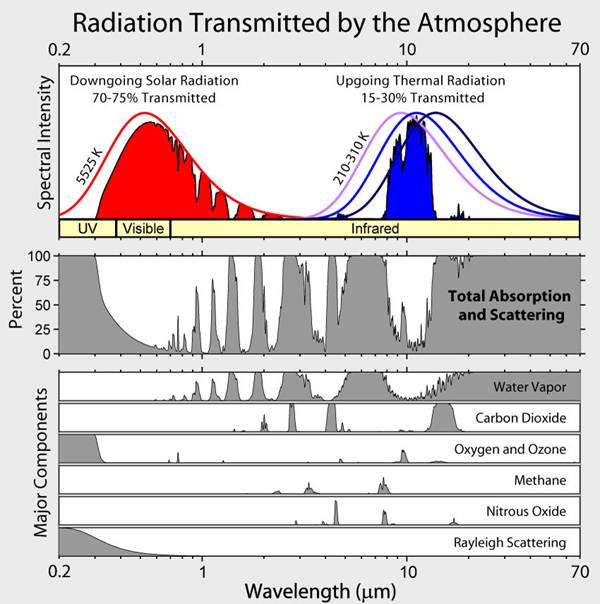

Le panneau supérieur du graphique ci-dessus montre

l'intensité spectrale d'absorption des gaz à effet de serre. La majeure

partie du rayonnement solaire à courte longueur d'onde dans la partie visible

du spectre est transmise à la surface. La majeure partie du rayonnement

thermique ascendant à ondes longues de la surface est absorbée, sauf dans la

fenêtre atmosphérique indiquée par la région bleue. Environ 16% du rayonnement à ondes

longues est transmis directement dans l'espace et le reste est absorbé par les

gaz à effet de serre.[MT5] Le panneau du milieu montre les

bandes d'absorption totales par longueur d'onde du rayonnement solaire

descendant et du rayonnement thermique ascendant. L'ombrage gris à 100 %

indique que l'énergie est entièrement absorbée à cette longueur d'onde. Le

panneau inférieur montre l'absorption des principaux gaz à effet de

serre.

Comparaison du CO2 et du H2O

Les spectres d'absorption d'H2O montrent qu'une grande partie du spectre

du CO2 chevauche celui de

l'eau. Certaines parties du spectre du CO2 sont déjà entièrement saturées. L'ajout

de plus de CO2 entraînera des effets de plus en

plus faibles à mesure que davantage de longueurs d'onde disponibles deviendront

saturées. La réponse de la température à l'ajout de CO2 dans l'atmosphère dépend de la

quantité de rétroactions positives et négatives de la vapeur d'eau, des nuages

et d'autres sources. L'effet de la température de

l'augmentation de la concentration de CO2 est approximativement

logarithmique. Cela

signifie que si le doublement du CO2 concentration de 300 ppm à 600 ppm, une augmentation

de 300 ppm, fait augmenter la température de 1 °C, [MT6] il faudrait une autre augmentation de 600

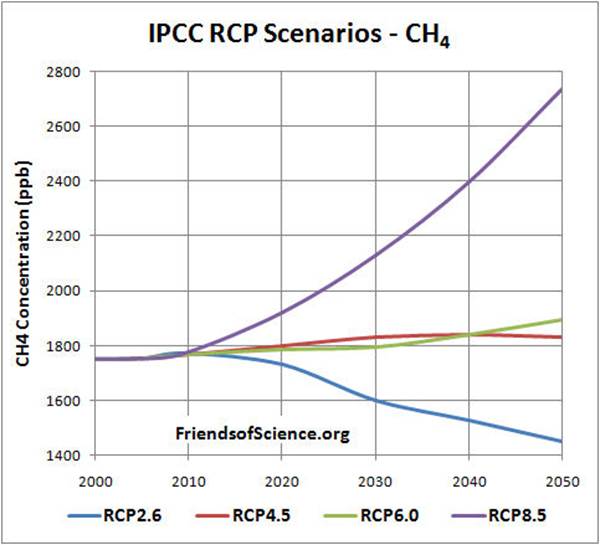

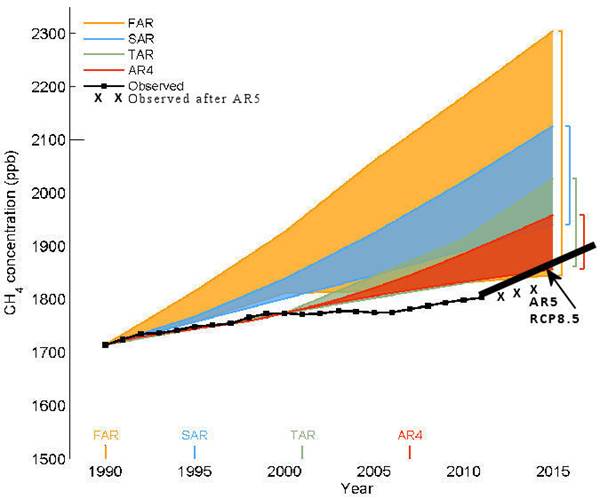

ppm pour ajouter un gain de température supplémentaire de 1 °C. Le méthane

a une bande d'absorption (à 8 micromètres) qui chevauche largement la vapeur

d'eau, de sorte qu'une augmentation du méthane a peu d'effet sur la

température.

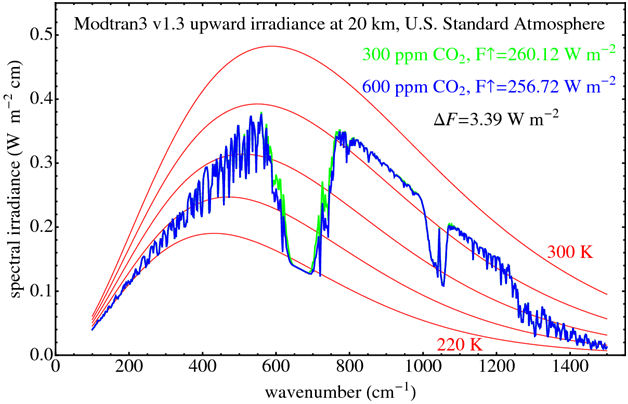

Le

diagramme ci-dessus montre le spectre de rayonnement ascendant du haut de

l'atmosphère à 20 km avec 300 ppm de CO2 et 600 ppm de CO2 [MT7] tel que calculé par le code radiatif

MODTRAN. (Notez que l'axe horizontal de ce diagramme montre le nombre

d'ondes, ou le nombre de longueurs d'onde par cm, qui est l'inverse de la

longueur d'onde en micromètres utilisée dans le diagramme précédent.) Ce modèle

calcule le rayonnement est très similaire à ce qui est réellement mesuré par

les satellites depuis espace. La courbe verte montre le spectre

d'émissions avec 300 ppm de CO2 dans l'atmosphère et la courbe bleue

montre le spectre avec 600 ppm de CO2 avec la même température de surface

et le même profil de vapeur d'eau. Le modèle montre que doubler le CO2la concentration modifie le spectre

uniquement aux bords de la bande principale d'absorption du CO2, à 600 et 740 cm -1. Le forçage résultant de 3,39

W/m 2 entraînerait une augmentation des

températures de surface si elle n'était pas compensée par des rétroactions

négatives.

CO2 par rapport à la contribution de

l'eau

Le CO 2 , la vapeur d'eau et les nuages

contribuent le plus à l'effet de serre. Diverses sources

donnent des estimations contradictoires des contributions de ces composants à

l'effet de serre. Le spectre d'absorption infrarouge des gaz à effet de

serre atmosphériques est très complexe. Dans certaines régions, les

fréquences d'absorption de divers gaz à effet de serre se chevauchent, de sorte

que les contributions de chaque composant ne s'additionnent pas de manière

linéaire. Le rayonnement à une fréquence particulière peut être absorbé

par la vapeur d'eau ou le CO2. La concentration de vapeur d'eau

dépend de la température et varie considérablement selon la latitude et

l'altitude. De plus, l'eau passe d'un liquide à un gaz avec de l'énergie

thermique pour la chaleur latente d'évaporation nécessaire à la transformation.

La plupart des sources placent l'effet de serre à 33 °C[MT8] . Il s'agit de la différence entre la

température actuelle de la surface de l'air (15 °C) et la température sans

l'effet de serre des gaz et des nuages, mais les nuages

continuant à refléter 31 % du rayonnement solaire entrant.

La nature n'attribue pas la contribution des différents gaz à

effet de serre - seul l'effet total est significatif. Néanmoins, une

estimation approximative des contributions peut être faite. La

contribution relative de l'eau, des nuages et du CO2 à l'effet de serre peut

être estimée de deux manières; en estimant à

partir de modèles de rayonnement le changement de l'effet de serre en

supprimant un composant, et en estimant l'effet de serre d'avoir seulement ce

composant dans l'atmosphère. Si l'on supprime l'effet de serre de la

vapeur d'eau et des nuages, les composants restants piégeraient 34 % de la

chaleur, ce qui implique que la vapeur d'eau et les nuages

piégeraient 66 %, comme indiqué dans la colonne "Chaleur non

piégée" du tableau ci-dessous. La somme des composantes calculées de

cette façon n'est que de 80 % de l'effet de serre dû au chevauchement des

spectres d'absorption. De même, si l'on n'inclut que la vapeur d'eau et

les nuages (pas de CO2, O3 ou autre), ils piégeraient 85 % du

rayonnement à ondes longues. Cependant, les contributions de chaque

composant totalisent 126 % de l'effet de serre.

Il est raisonnable d'allouer simplement le chevauchement

proportionnellement à chaque composant, de sorte que l'effet est normalisé dans

les colonnes "Effet relatif" de sorte que la somme des effets soit

égale à 100 %. Ce calcul suggère que la vapeur d'eau et les nuages

contribuent de 70 % à 80 % et que le CO2 contribue de 10 % à 20 % à l'effet de

serre, comme indiqué dans le tableau ci-dessous [MT9] :

Modification de l'absorption des ondes

longues

|

Composant |

Retirer le composant emprisonné par la

chaleur |

Chaleur non emprisonnée |

Effet relatif |

Composant uniquement emprisonné par la

chaleur |

Effet relatif |

Moyenne des méthodes |

|

Aucun |

100 |

0 |

|

|

|

|

|

Eau & Nuages |

34 |

66 |

82.5% |

85 |

67.5% |

75.0% |

|

CO2 _ |

91 |

9 |

11.3% |

26 |

20.6% |

15.9% |

|

O 3 |

97 |

3 |

3.8% |

7 |

5.6% |

4.7% |

|

Autre |

98 |

2 |

2.5% |

8 |

6.3% |

4.4% |

|

Total |

|

80 |

100.0% |

126 |

100.0% |

100.0% |

Cela donne une estimation approximative de la

contribution des composants à l'effet de serre total actuel, mais cela ne nous

dit presque rien de l'effet supplémentaire de la modification de la

concentration d'un composant.

La vapeur d'eau est le gaz le plus important de l'effet de

serre. La vapeur d'eau est généralement considérée comme une rétroaction,

tandis que le CO2 est considéré comme un forçage car

le temps de séjour d'un changement de concentration de vapeur d'eau est très

court par rapport au CO2 . Les

émissions d'origine humaine dans l'eau (autres que les avions à haute altitude)

n'ont pas d'effet significatif sur le climat, mais l'eau peut avoir un effet

significatif en tant que rétroaction sur un changement de température initié

par le soleil ou les émissions de CO2.

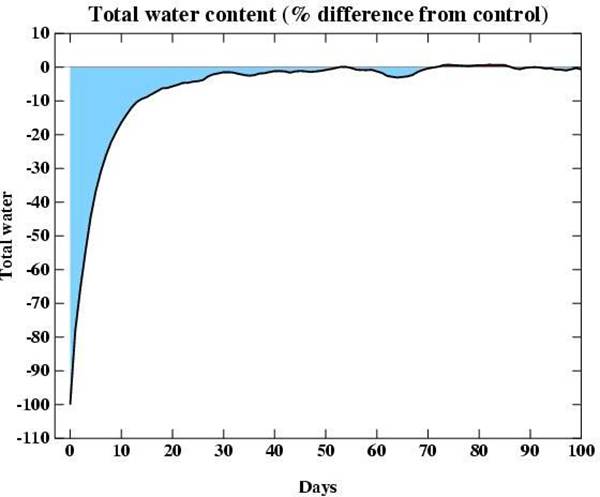

Si l'on enlevait comme par magie 20% de toute la vapeur d'eau dans

l'atmosphère, l'eau s'évaporerait rapidement des océans pour la remplacer de

sorte qu'en 20 jours la concentration en eau serait de 99% de la valeur

d'origine comme le montre le graphique ci-dessous.

De même, si les humains doublaient soudainement nos

émissions d'eau de la surface, en quelques jours, l'augmentation de la

vapeur d'eau pleuvrait, laissant la concentration de vapeur d'eau presque

inchangée. Le graphique ci-dessus et les valeurs d'absorption ont été

calculés à l'aide du modèle

de circulation générale du Goddard Institute for Space Studies .

Ces calculs n'incluent pas les effets des avions. Il fait si

froid à l'altitude à laquelle les avions volent qu'il

n'y a pratiquement pas de vapeur d'eau. La seule fois où l'eau devient

aussi élevée, c'est lorsque les températures élevées du sol provoquent un

soulèvement thermique entraînant de l'eau avec elle. Il fait trop froid

là-haut pour que l'eau existe sous forme de vapeur, donc des gouttelettes se

forment et nous voyons cela comme des traînées de vapeur d'avion. Ce sont

des nuages artificiels d’un type tel qu’ils piègent le

rayonnement infrarouge mais laissent passer la lumière du soleil, créant ainsi

un effet de réchauffement. La vapeur d'eau injectée dans la haute

atmosphère a un temps de séjour beaucoup plus long que l'eau injectée dans

l'atmosphère près de la surface, elle peut donc avoir un effet mineur sur le

climat.

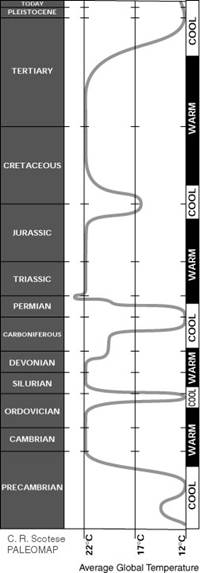

Le climat change constamment

L'histoire

de la Terre montre que le climat a toujours changé, à court et à long terme[MT10] . Ces changements ont parfois été brusques et

sévères, sans aucune aide humaine. Les reconstructions de la température

climatique sont déterminées à partir de diverses sources, telles que des études

sur la largeur des cernes des arbres et les sédiments du fond

océanique. Au cours des 2 derniers milliards d'années, la Terre a alterné

des périodes fraîches comme aujourd'hui, et des périodes chaudes comme lorsque

les dinosaures parcouraient la planète. La figure ci-dessous à gauche est une

reconstruction de la température de la Terre sur 2 milliards d'années. Les

températures sur cette période sont déterminées en cartographiant la

répartition des charbons anciens, des dépôts désertiques, des sols tropicaux,

des dépôts salins et glaciaires, ainsi que la répartition des plantes et des

animaux sensibles au climat, tels que les alligators, palmiers et

mangroves. Voir ici pour plus d'informations .

Température au fil du

temps géologique

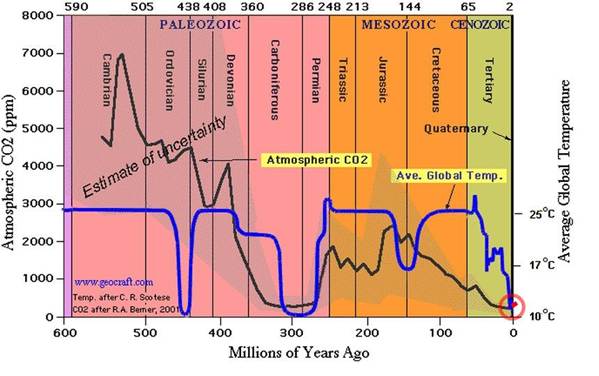

Le graphique ci-dessus à droite vient d' ici et montre que les niveaux de CO2 ont diminué depuis la fin de la

période jurassique jusqu'au début de l'ère industrielle. Le changement de

CO2 indiqué par la ligne rouge dans le

cercle rouge est le changement de CO2 depuis la révolution industrielle.

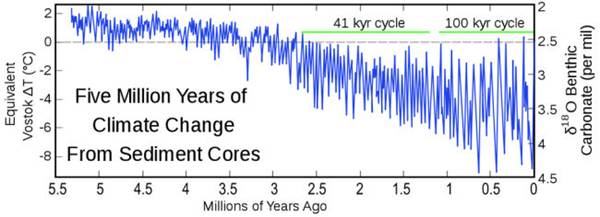

Le graphique ci-dessous montre cinq millions d'années de

changement climatique en combinant les mesures de 57 carottes de sédiments

marins profonds réparties dans le monde. La quantité mesurée est la

fraction isotopique de l'oxygène 18, qui est une approximation de la

température.

Les données proviennent de Lisiecki et Raymo , 2005. L'échelle de température a

été définie en ajustant les variations de température signalées à Vostok, en Antarctique, aux variations isotopiques

observées, de sorte que l'échelle de température est représentative des

changements de Vostok.

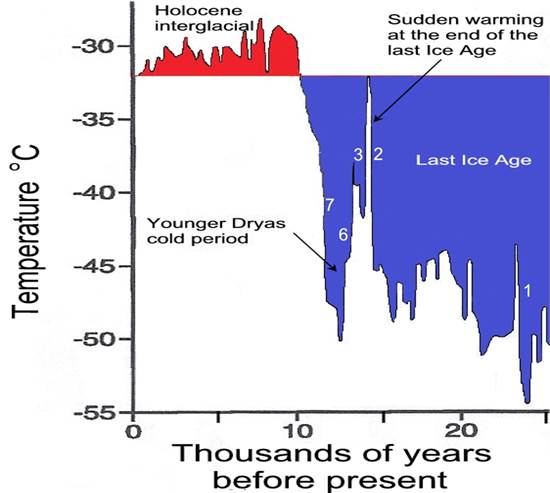

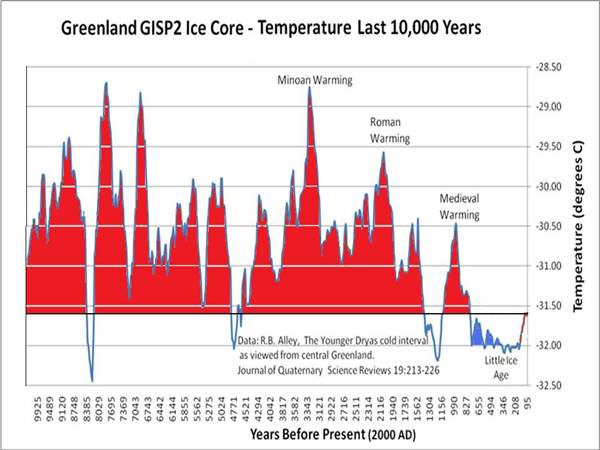

Le graphique ci-dessus à partir d'ici montre 25 000 ans d'histoire de la

température du Groenland déterminée à partir du deuxième projet de l'inlandsis

du Groenland (GISP2). Après 5 ans de forage à travers la calotte glaciaire

dans le substratum rocheux jusqu'en juillet 1993, une carotte de glace de 3053

m a été récupérée. En mesurant le rapport de deux isotopes de l'oxygène

(spécifiquement 18 O au bien plus commun 16O) on peut en déduire la température de

l'air au moment de la cristallisation de la neige de chaque couche

annuelle. Cette technique est considérée comme assez précise. Un

réchauffement fort et brusque se manifeste par une élévation presque verticale

des températures, un fort refroidissement par une chute presque verticale des

températures (Modifié de Cuffy et Clow,

1997). Le Dr Don Easterbrook écrit:

"Les changements de température

enregistrés dans la carotte de glace GISP2 ... montrent que le réchauffement

climatique subi au cours du siècle dernier est insignifiant par rapport à

l'ampleur des profonds renversements climatiques au cours des 25 000 dernières

années. De plus, de petites des changements de température allant jusqu'à un

degré environ, semblables à ceux record observés au 20e du siècle, se produisent de manière

persistante tout au long de l'ancien record climatique. ... Au cours des

25 000 dernières années, au moins trois événements de réchauffement ont été de

20 à 24 fois l'ampleur du réchauffement au cours du siècle dernier et quatre

ont été de 6 à 9 fois l'ampleur du réchauffement au cours du siècle

dernier."

Résultats des carottes de glace du Nord Groenland Eemian Ice Drilling (NEEM) publié

en janvier 2013 pour la période chaude du dernier interglaciaire d'il y a 128

000 à 122 000 ans, connue sous le nom d'Eemian, était

de 8 +/- 4 °C plus chaude que le dernier millénaire. Une carotte a été forée de

2008 à 2012. Les résultats complets sont présentés dans " Eemian interglacial reconstruit à partir d'une carotte de

glace plissée du Groenland ".

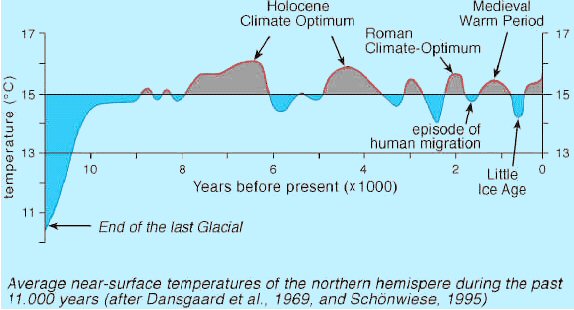

Historique des

températures dans l'hémisphère nord

Le graphique ci-dessus montre l'historique des

températures de l'hémisphère nord depuis la dernière période glaciaire.

Le graphique ci-dessus montre les températures du

Groenland telles que déterminées par la carotte de glace GISP2. Il s'agit

d'une version détaillée d'un graphique précédent ci-dessus, à partir d' ici .

Historique de la température

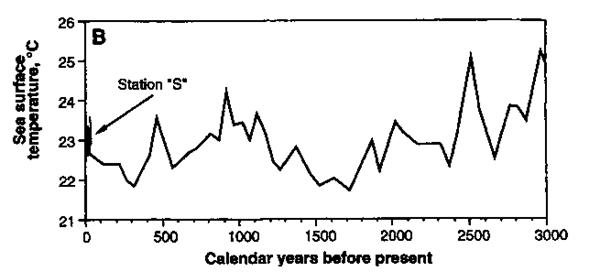

des sédiments de l'océan Atlantique Nord

Le graphique ci-dessus montre les variations de

température des 3 000 dernières années (au cours de l'histoire enregistrée),

telles que déterminées à partir d'études sur les sédiments océaniques dans

l'Atlantique Nord. [Keigwin, 1996]. Notez

les variations rapides, ainsi que les températures beaucoup plus chaudes il y a

1 000 et 2 500 ans.

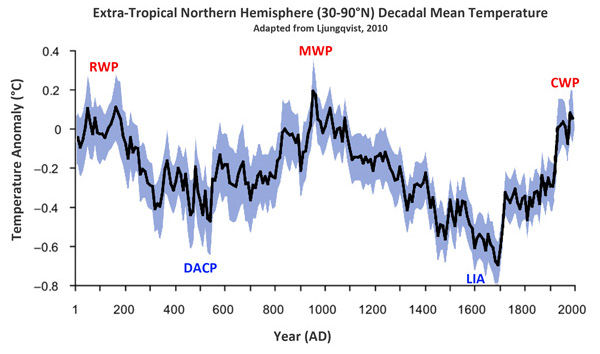

Une nouvelle reconstruction de température avec une résolution

décennale, couvrant les deux derniers millénaires, est présentée ci-dessous

pour l'hémisphère Nord extratropical (90-30 N), utilisant de nombreux

enregistrements proxy de paléo-température, de Ljungqvist

2010 ici . L'ombrage représente 2 écarts

type.

|

RWP = période chaude romaine AD 1-300 |

DACP = période froide de l'âge sombre 300-900 |

|

MWP = période chaude médiévale 800-1300 |

LIA = Petit âge glaciaire 1300-1900 |

|

CWP = période chaude actuelle 1900-présent |

|

Les données indirectes montrent que certaines parties

de la période chaude romaine et de la période chaude médiévale étaient aussi

chaudes que les années 1940. La figure 3 de l'article de Ljungqvist 2010 montre que les températures décennales exotropes du nord HadCRUT3 des années 1990 étaient

supérieures d'environ 0,15 °C au pic du MWP, mais les données indirectes n'ont

pas enregistré la hausse de température de la seconde moitié du XXe siècle.

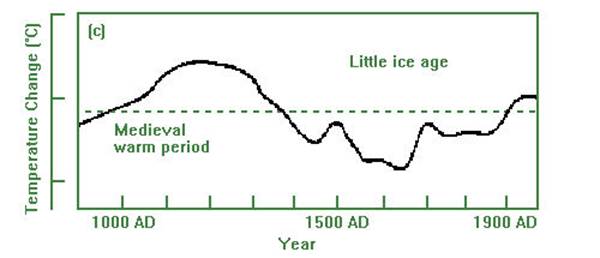

Le climat est en constante évolution, comme le montre l'histoire

de la température de l'Europe au cours des mille dernières années dans le

graphique ci-dessous.

1000 ans d'histoire de la

température IPCC 1990

L'historique des températures ci-dessus a été publié

dans le premier rapport du GIEC en 1990, basé sur l'histoire climatique estimée

de Lamb pour le centre de l'Angleterre.

De toute évidence, l'activité humaine n'a pas pu avoir d'effet

significatif sur les changements de température avant 1900. Ces changements

sont le résultat de processus naturels.

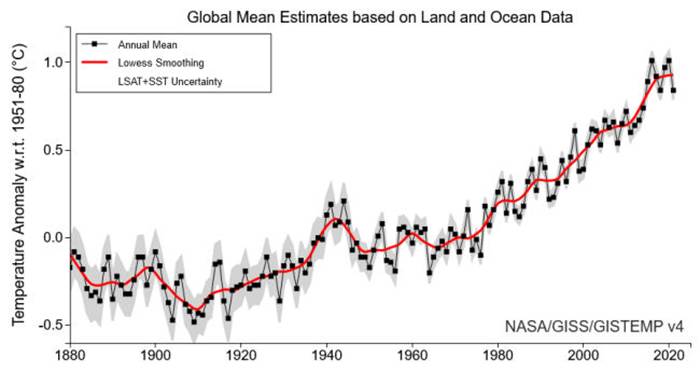

Les graphiques de température GISS de la NASA depuis 1880 peuvent

être trouvés ici . Le graphique ci-dessous

montre l'historique des températures mondiales annuelles du GISS. La

dernière année affichée est 2021

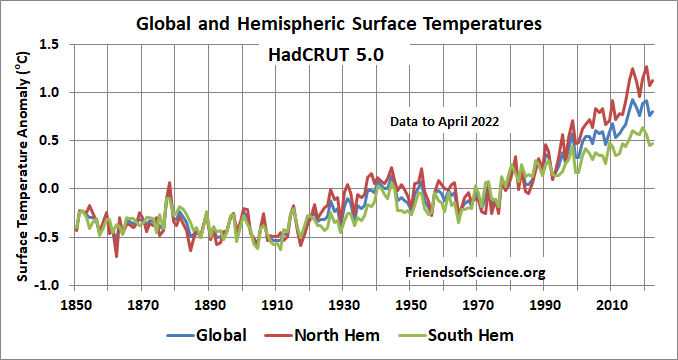

Le graphique ci-dessous montre les températures

annuelles HadCRUT5 de 1850 à 2022.

HadCrut5 est l'indice global de température de surface

produit par le Hadley Center et le Climate Research Unit, Angleterre. Il combine les données de

température terrestres et marines. Le graphique ci-dessus à partir d'ici montre les températures annuelles de

l'hémisphère nord, de l'hémisphère sud et de la surface mondiale de 1850 à

2022. 2022 est basé sur une année partielle.

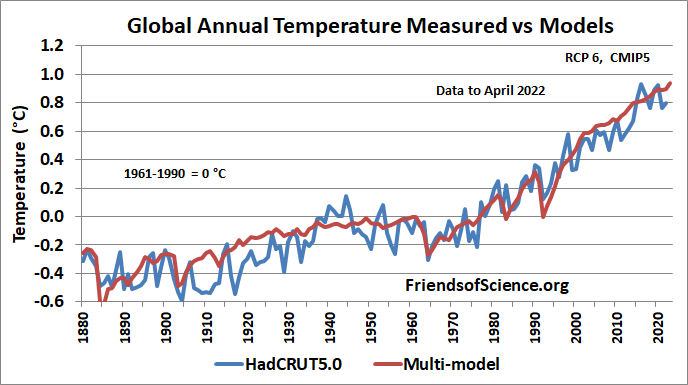

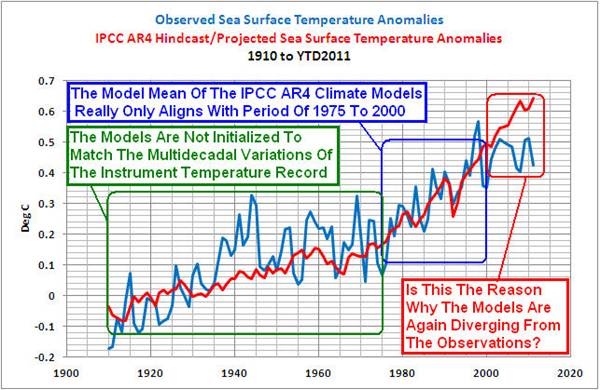

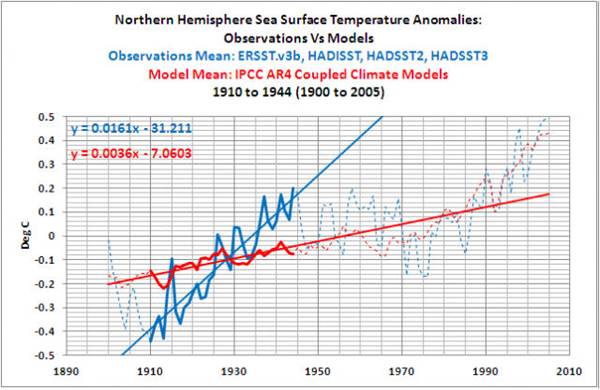

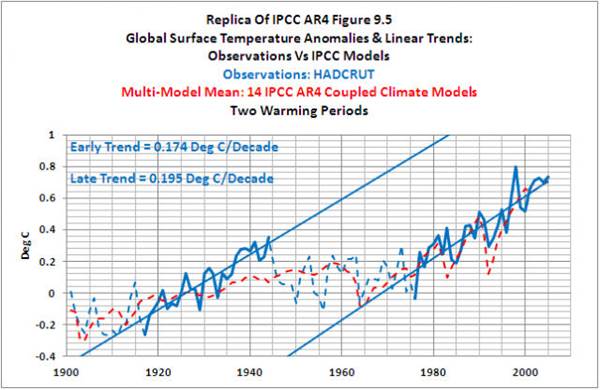

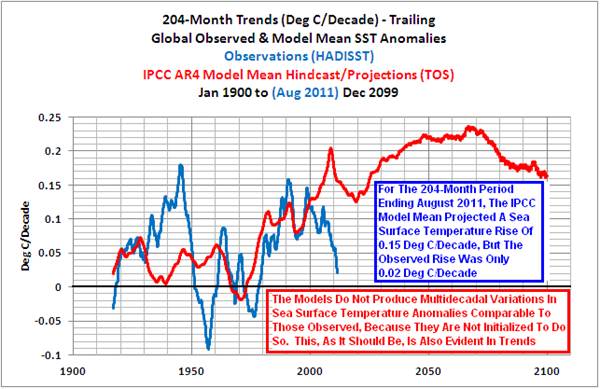

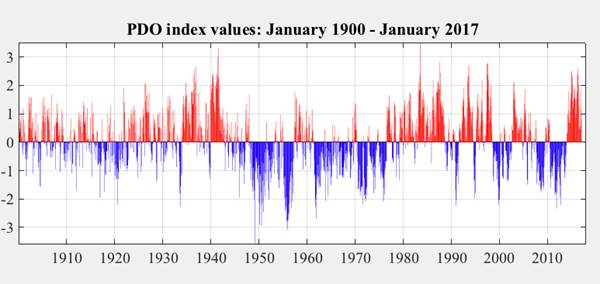

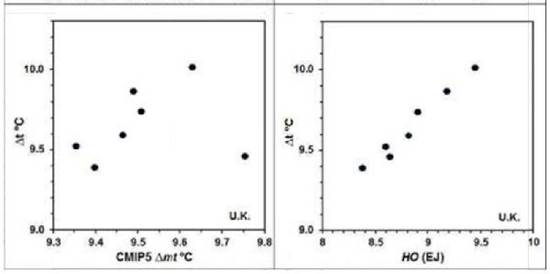

La moyenne multi-modèle ne représente pas bien les oscillations

multi-décennales mais correspond par ailleurs assez bien à la température

mesurée jusqu'en 2000. Les

modélisateurs utilisent un forçage négatif élevé des aérosols pour compenser la

trop grande sensibilité des modèles aux gaz à effet de serre. Les modèles

chauffent trop au 21e siècle malgré des mesures trop élevées en raison de la

contamination due au réchauffement urbain.

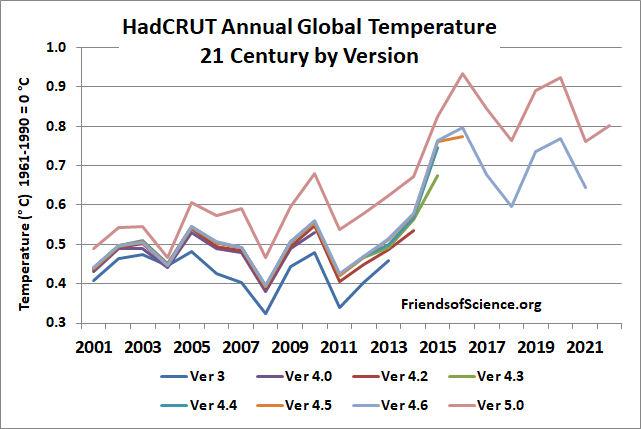

L'ensemble de données HadCRUT3 a été interrompu en mai

2014. L'ensemble de données HadCRUT4 a été introduit pour ajouter plus de

couverture dans la région polaire nord. L'ensemble de données HadCRUT5 est

une analyse statistique remplie qui étend la couverture dans les régions où les

données sont rares. Le graphique ci-dessous montre une comparaison sur les

jeux de données HadCRUT3, versions HadCRUT4.0 et 4.2 à 4.6 et HadCRUT5.0.

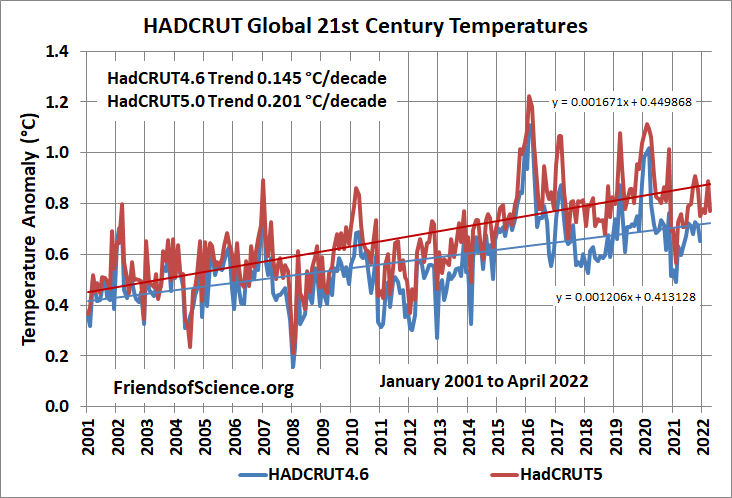

Le graphique ci-dessous montre les températures

mensuelles mondiales du 21e siècle à partir des ensembles de données HadCRUT4.6

et HadCRUT5.0, avec les tendances linéaires les mieux ajustées.

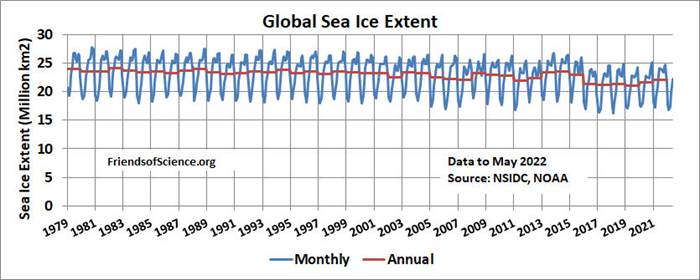

La zone de glace de mer a fait l'objet de beaucoup

d'attention, car il est prévu que l'AGW réchauffe les régions polaires beaucoup

plus que les autres zones. Le graphique ci-dessous montre l'étendue

mondiale de la banquise par mois et annuellement à partir des données

satellitaires trouvées ici . L'étendue de la glace de mer

est définie comme la zone de chaque pixel de données satellitaires qui contient

au moins 15 % de glace de mer.

L'étendue

mondiale de la banquise a été variable avec une faible étendue en 2007 et 2011.

L'étendue de la banquise a augmenté en 2013 mais était plus faible en 2016 et a

augmenté en 2020 et 2021[MT11] . Voir ici pour les graphiques de l'étendue de

la banquise arctique et antarctique.

La température

entraîne les changements de CO2

La température de la Terre s'est légèrement

réchauffée, d'environ 0,8 degrés Celsius, au cours du 20 e siècle. Au cours de cette

période, la concentration de CO2 dans l'atmosphère a augmenté,

principalement en raison de l'utilisation accrue de combustibles

fossiles. Cependant, le Soleil a augmenté d'intensité depuis 1900, ce qui

peut avoir induit une grande partie du réchauffement observé depuis lors. Scafetta et West estiment que le Soleil pourrait avoir

causé 10 à 20 % de l'augmentation du CO2 au cours du siècle

dernier. (Voir [7] dans leur article .) Une corrélation à court terme

n'implique pas que l'augmentation du CO2 ait causé l'augmentation de la

température. La causalité peut être déduite s'il existe une corrélation

sur plusieurs cycles de changements de concentration de CO2, avec le changement de CO2 précédant le changement de température. L'histoire climatique

réelle ne montre pas une telle corrélation, et il n'y a aucune preuve

convaincante que la récente augmentation de la température ait été causée par

le CO2. Les températures ont été variables

au fil du temps et ne sont pas corrélées à la concentration de CO2. Lorsque les concentrations de CO 2 étaient 10 fois plus élevées

qu'elles ne le sont aujourd'hui, nous étions dans une grande ère glaciaire. En

tant que gaz à effet de serre, le CO2 est largement compensé par la vapeur

d'eau (naturelle) et les nuages, qui représentent plus de 70 % de l'effet de

serre. Les émissions de CO2 d'origine humaine ont grimpé en

flèche après 1940. Pourtant, la plus grande partie de l'augmentation de la

température mondiale du 20 e siècle s'est produite

avant. Voir ici pour un

graphique du cycle du carbone.

La concentration de CO 2 avec les températures de la basse

troposphère de l'UAH est indiquée ci-dessous. La concentration annuelle

moyenne de CO 2 est passée de 376,8 parties par

million (ppm) en 1979 à 416,5 ppm en 2021.

L'augmentation réelle de la concentration de CO2 a été en moyenne de 0,5 % par an

depuis 1990 et est actuellement d'environ 0,6 %/an.

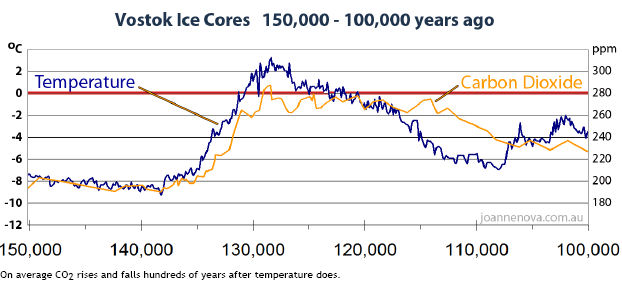

Fischer et al. (1999) ont examiné les relevés du CO2 atmosphérique et de la température

de l'air tirés des carottes de glace de l'Antarctique Vostok

qui remontent dans le temps sur un quart de million d'années. Au cours de

cette immense période de temps, les trois événements de réchauffement les plus

spectaculaires sur terre ont été ceux associés à la fin des trois dernières

périodes glaciaires ; et pour chacun de ces énormes réchauffements

planétaires, la température de l'air terrestre a augmenté bien avant qu'il y

ait eu une augmentation du CO2 atmosphérique. En effet, le CO2 contenu

dans l’air n'a commencé à augmenter que 400 à 1 000 ans après le début du

réchauffement de la planète. Les carottes de glace fournissent un

enregistrement détaillé de la température locale et des concentrations de

CO2.

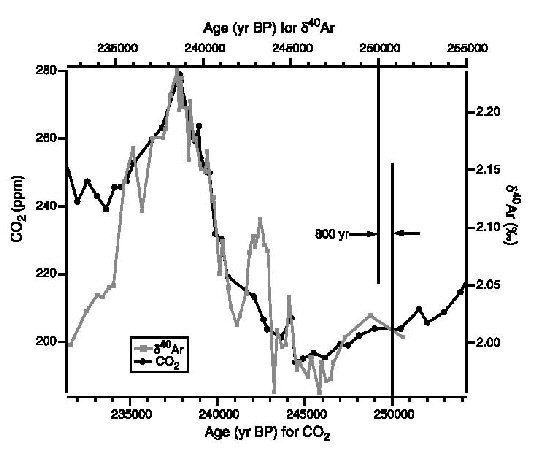

Une

étude de Caillon et al. (2003) constatent que l'augmentation du CO2 a retardé le réchauffement de

l'Antarctique de 800 + ou - 200 ans. Les auteurs ont mesuré la composition

isotopique de l'argon 40 et la concentration de CO2 dans les bulles d'air du noyau de Vostok à la fin de la troisième période glaciaire la plus

récente (Termination III), 240 000 ans avant le

présent. L'isotope argon 40 s'avère être un excellent indicateur de

température.

Les données des carottes de glace de Vostok sur la fin du troisième âge glaciaire BP Les

échelles d'âge du

CO 2 et de l'argon (température) sont

décalées de 800 ans

La concentration de CO2 indiquée par la ligne noire est

tracée en fonction de l'âge en années avant le présent (BP) sur l'axe

inférieur, et l'Argon 40, un proxy de température, indiqué par la ligne grise

est tracée en fonction de l'âge sur l'axe supérieur. L'échelle d'âge du CO2 a été décalée de 800 ans constants

pour obtenir la meilleure corrélation des deux ensembles de données. La

corrélation montre que les changements de température précèdent les changements

de concentration de CO2 d'environ 800 ans.

Ces découvertes confirment qu'une augmentation du CO 2 n'a jamais provoqué initialement une

augmentation de la température lors d'une déglaciation. L'augmentation

de la température entraîne le dégazage du CO2 par

les océans car le CO2 est

plus soluble dans l'eau froide, ce qui augmente le CO2 contenu

de l'atmosphère. Lorsque

la température atteint son maximum à chaque cycle et commence à

chuter, les concentrations de CO2 continuent d'augmenter pendant encore 800

ans ! Lorsque le CO2 augmente, les températures

chutent. C'est le contraire de ce à quoi on pourrait s'attendre si le CO2 était le principal facteur

climatique. Les données des carottes de glace prouvent que le CO2 n'est pas le principal facteur

climatique. Il faut invoquer une causalité temporelle inverse pour

affirmer que les données des carottes de glace montrent que le CO2 provoque des changements de

température, comme suggérer que les actions prises aujourd'hui peuvent affecter

les conquêtes du chef mongol Gengis Khan. La logique exige que la cause

précède l'effet. L'augmentation de la température de l'air entraîne une

augmentation de la concentration atmosphérique de CO2.

Une partie plus récente de l'enregistrement des carottes de glace

de Vostok du Skeptics Handbook #1 de Joanne Nova, trouvé ici , est présenté ci-dessous.

Voir CO 2 Science pour plus

d'informations. Voir ici pour l'article de Cailion et al (2003). Un graphique des données de la

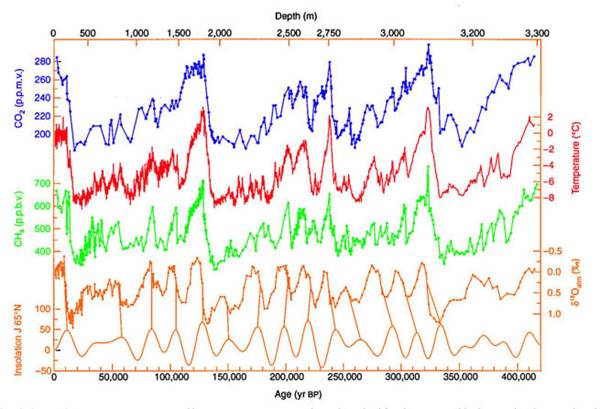

carotte de glace de Vostok sur 420 000 ans est

présenté ci-dessous. Une grande version est ici .

L'activité solaire est en corrélation avec

la température

De nombreux articles

publiés dans les principales revues scientifiques à comité de lecture montrent

que le Soleil est le principal moteur du changement climatique. Il existe

une très forte corrélation entre l'activité solaire et la température.

Au début du XIXe siècle, William Herschel (1738-1822), découvreur

d'Uranus, a constaté que cinq périodes de faible nombre de taches solaires

correspondaient à des prix élevés du blé lorsque les températures étaient

froides. (Le climat froid réduit l'offre de blé, entraînant une hausse de

son prix.) Voir " The Varying Sun & Climate Change ", Soon

& Baliunas, 2003.

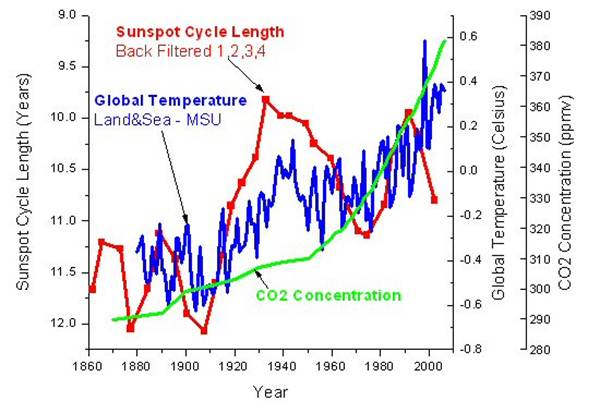

E. Friis-Christensen et K.Lassen ont montré que la longueur du cycle moyen des

taches solaires de 11 ans est corrélée à la température de l'hémisphère nord au

cours des 130 dernières années. La durée du cycle des taches solaires est

connue pour varier avec l'activité solaire, alors qu'une activité solaire

élevée implique une courte durée du cycle des taches

solaires. Voir ici

pour plus d'informations .

Voir ici

pour un graphique mis à jour basé sur la méthodologie de Friis-Christensen et Lassen.

Voici une corrélation entre la durée du cycle des taches solaires,

la température globale et les concentrations de CO 2 .

Durée du cycle des taches

solaires Température et CO 2

Les carrés rouges sur le graphique représentent les

durées du cycle des taches solaires. Un point est la longueur du cycle

depuis le moment du nombre maximum de taches solaires jusqu'au moment du nombre

maximum de taches solaires du cycle suivant, et le point suivant est la

longueur du cycle depuis le moment avec un nombre minimum de taches solaires

jusqu'au moment avec le nombre minimum de taches solaires du prochain

cycle. Les cycles de taches solaires sont rétrofiltrés en utilisant la

pondération 1,2,3,4 appliquée à chaque point de cycle, à la fois min à min et

max à max. Cela suppose que le cycle actuel a le plus d'effet sur la

température (poids 4) et que les demi-cycles précédents affectent les

températures actuelles en quantités décroissantes, mais que les cycles futurs

n'ont aucun effet sur la température actuelle. La courbe de température en

bleu a utilisé les données terrestres et maritimes HadCRUT3 jusqu'en 1978, les

données satellitaires MSU de 1984 à 2006, et la moyenne des ensembles de

données pour 1979 à 1983. Cela élimine une grande partie des effets d'îlots de

chaleur urbains. Les températures sont annuelles non filtrées. Le CO2 concentrations (ppmv) de 1958 à 2007

sont dérivées d'échantillons d'air prélevés à l'observatoire du Mauna Loa, à Hawaï. Les concentrations de CO2 avant 1958 sont incertaines.

Notez qu'il existe une

correspondance entre la durée du cycle des taches solaires et la température. Les courbes de température et de durée de cycle commencent à

augmenter à 1910, et les températures chutent après 1945 à 1975 lorsque la

courbe de durée de cycle tombe, et les deux courbes augmentent à nouveau après

1975. Les températures ont augmenté depuis 1980 plus rapidement que ce qui peut

être expliqué par la durée du cycle des taches solaires, indiquant une

éventuelle contribution de CO2 d’origine

humaine. L'augmentation récente des longueurs de cycle explique pourquoi

il n'y a pas eu de réchauffement depuis 2002. Les changements de température

devraient suivre les changements d'activité solaire en raison d'un décalage

temporel résultant de la grande capacité thermique des océans.

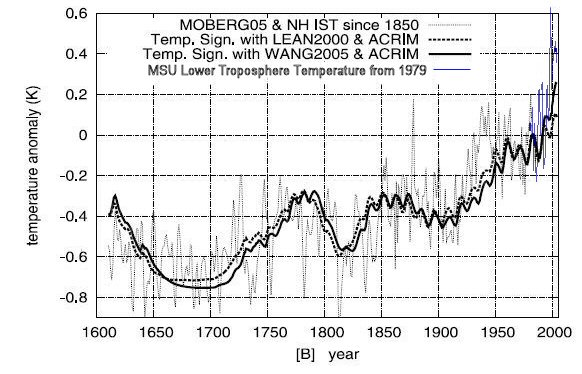

N. Scafetta de Duke University,

Durham, NC et BJ West du US Army Research

Office, NC ont étudié l'impact solaire sur 400 ans des températures de

l'hémisphère nord depuis 1600. Ils trouvent une bonne correspondance entre la

température et les reconstructions proxy d'irradiance solaire jusqu'en 1920

comme indiqué sur le graphique ci-dessous.

Température de l'hémisphère

nord vs rayonnement solaire 400 ans

La courbe de température est dérivée des

enregistrements proxy jusqu'en 1850 par Moberg et

al. [2005], et à partir de données instrumentales sur la température de

surface de 1850 à environ 1980. L'enregistrement de la température de surface

comprend l'îlot de chaleur urbain (UHI) et les effets des changements

d'utilisation des sols. L'enregistrement

de la basse troposphère MSU de l'hémisphère nord est affiché à partir de 1979

en bleu, ce qui élimine la plupart des effets UHI. Deux

reconstructions proxy d'irradiance solaire différentes sont présentées : Lean,

2000 ; Wang et al., 2005. Les deux courbes fusionnent les données

satellitaires ACRIM depuis 1980 avec les données proxy. En supposant

ACRIM, l'activité solaire a une tendance à la hausse durant la seconde moitié

du 20ème siècle. Ce graphique est une

modification de la version créée par Scafetta et

West, qui utilise l'enregistrement de l'instrument mesuré après 1979 au lieu

des données satellitaires. Voir la version originale ici .

Notez les périodes de

faible activité solaire se produisant pendant le minimum de Maunder

(1645 à 1715, le petit âge glaciaire) et pendant le minimum de Dalton (1795 à

1825).

Notez l'excellente corrélation de 1600 à 1900 lorsque les humains

étaient peu susceptibles d'affecter le climat. Au cours du XXe siècle, on continue d'observer une

corrélation significative entre les modèles solaires et thermiques : les

deux enregistrements montrent une augmentation de 1900 à 1950, une diminution

de 1950 à 1970, et à nouveau une augmentation de 1970 à 2000.

Une divergence des courbes par rapport au graphique original de Scafetta et West indique que le Soleil est responsable de

56% en utilisant Lean 2000, et de 69% en utilisant Wang 2005, du réchauffement

de l'hémisphère nord de 1900 à 2005. Les auteurs estiment l'erreur à 20% .

Deux bases de données solaires sont disponibles à partir des

données satellitaires. L'ACRIM est obtenu directement à partir de données

satellitaires de haute précision.

Il y a une lacune (1989 - 1992) dans l’enregistrement du satellite

qui était due à un retard dans le lancement d'un nouveau satellite ACRIM après

la catastrophe du challenger de la navette spatiale de 1986. Le retard a

causé un écart de deux ans dans le système ACRIM qui mesure l'irradiance

solaire. Les seules données disponibles pour combler le vide provenaient

d'un moniteur différent appelé système de bilan radiatif terrestre (ERB), qui

n'était pas conçu pour surveiller le Soleil. Il avait peu de précision et

n'avait une vue du soleil que pendant de brefs intervalles de temps sur son

orbite. L'enregistrement de l'ACRIM a suggéré une augmentation de

l'irradiance solaire du début des années 1980 à la fin des années 1990. Un

groupe rival appelé PMOD a affirmé que les capteurs ERB avaient connu une

augmentation de sa sensibilité au cours de la période d'intervalle, ils ont

donc ajusté à la baisse les données du deuxième satellite ACRIM pour montrer

une baisse de l'intensité solaire. Dr Douglas Hoyt, le

scientifique qui avait été en charge de la mission du satellite ERB, a déclaré

« qu'il n'y a aucun changement physique connu dans le [système] calibré

électriquement qui aurait pu le rendre plus sensible. Et personne n'a

jamais proposé de théorie physique pour l'instrument qui pourrait le rendre

plus sensible. Les rapports du GIEC ont minimisé le rôle de l'activité

solaire dans le changement climatique récent en utilisant uniquement

l'interprétation de l'irradiance solaire PMOD.

Les auteurs ont fait une analyse similaire en utilisant la

reconstruction de la température de Mann et Jones 2003. Cette histoire de

température montre peu de variation avant 1900 et montre une forme de bâton de

hockey. Cette reconstruction a été sévèrement critiquée pour plusieurs

raisons. Voir la section Le bâton de hockey du GIEC de

cet essai. Les auteurs ont découvert que la reconstruction de Mann et

Jones 2003 (par rapport aux données Lean 2000) se traduit par un temps de

réponse nul non physique au forçage solaire. La grande capacité

calorifique de l'océan devrait entraîner un décalage temporel des températures

de surface par rapport aux changements solaires de plusieurs années, de sorte

que cette reconstruction ne peut pas être correcte.

L'analyse des auteurs montre que le Soleil a contribué de 50 à 69%

au réchauffement de la surface selon les reconstructions utilisées. Le reste

peut être dû au CO2, UHI et changements d'utilisation des

terres. Les auteurs comparent l'irradiance solaire aux températures de la

surface terrestre de l'hémisphère nord, qui sont contaminées par l'effet d'îlot

de chaleur urbain. Les

températures globales du satellite MSU, qui ne sont pas contaminées par l'effet

UHI, ont augmenté de moitié moins que les températures de l'hémisphère Nord

depuis 1980. Si l'analyse Scafetta et West

utilisait les données satellitaires non contaminées depuis 1980, les résultats

montreraient que le Soleil a contribué à au moins 75% du réchauffement

climatique du siècle dernier. En savoir plus sur l' effet

UHI plus loin dans cet essai. Voir ici pour l'article de novembre 2007.

Les alarmistes climatiques ont affirmé que l'activité solaire

n'avait rien à voir avec le réchauffement de la fin du 20ieme siècle parce que le nombre de taches solaires

a culminé vers 1960 puis a diminué tandis que les températures mondiales ont

augmenté au cours de la 2e moitié du 20 e siècle. La courbe d'activité

solaire, qui a été mise à jour en 2015, montre que l'irradiance solaire totale

a culminé en 1990 avec le cycle solaire 22. L'activité solaire n'est pas

seulement le nombre de taches solaires. Lüning

et Vahrenholt écrivent "Le soleil a non

seulement atteint son maximum à la fin du 20 e siècle, mais il était apparemment

plus fort qu'à tout moment au cours des 10 000 dernières années." Le

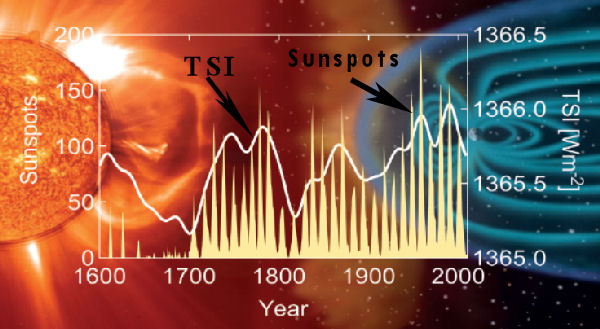

graphique ci-dessous montre le nombre de taches solaires et l'irradiance

solaire totale (TSI), origine .

Un groupe de

scientifiques de la NASA et d'universités ont trouvé des preuves convaincantes

d'un lien entre l'activité solaire et le climat en comparant les

enregistrements du niveau d'eau historique du Nil au nombre d'aurores observées

dans le nord de l'Europe et l'Extrême-Orient entre 622 et 1470. UN D. Les aurores sont des lueurs

brillantes dans le ciel nocturne après les éruptions solaires et constituent un

excellent moyen de suivre l'activité solaire. Voir ce lien

pour plus d'informations .

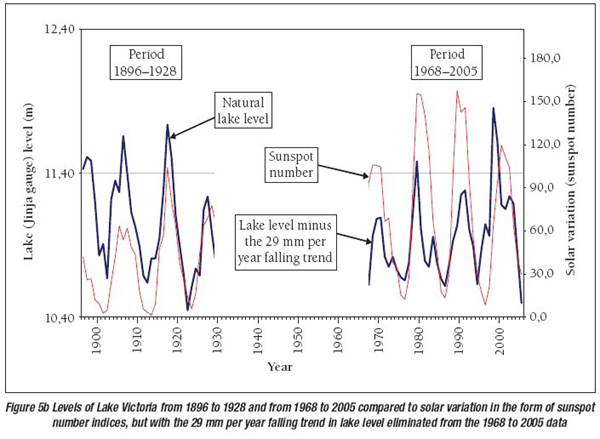

Une étude de WJR Alexander et al, publiée en juin 2007

a comparé les données hydrométéorologiques à la variabilité solaire. L'étude a examiné les

précipitations, le débit des rivières et les données sur les

inondations. Les auteurs concluent qu'il existe "un lien synchrone

sans équivoque entre ces processus en Afrique du Sud et ailleurs, et l'activité

solaire". L'étude comprenait une analyse du niveau du lac

Victoria, qui a été soigneusement surveillé depuis 1896. Au début des années

1960, une augmentation spectaculaire des précipitations a considérablement

élevé le niveau du lac, et le niveau depuis lors a baissé d'environ 29 mm par

an. La baisse a été supprimée des données tracées ci-dessous. Le

graphique montre deux périodes de forte corrélation entre le niveau du lac et

le nombre de taches solaires, correspondant à des périodes de niveaux élevés de

poussière volcanique.

Niveau d'eau du lac Victoria et nombre de

taches solaires

Voir l'article " Liens entre l'activité

solaire, la prévisibilité du climat et le développement des ressources en eau " ici .

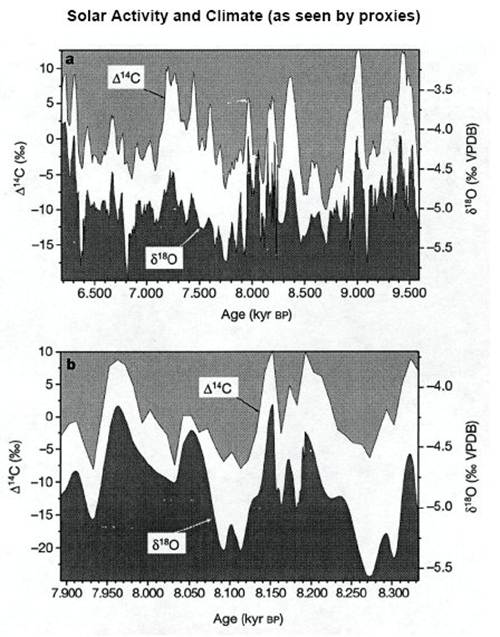

A plus long terme, voici une corrélation d'un proxy solaire à un

proxy de température pour une période de 3000 ans. Les valeurs de carbone

14 (produit par les rayons cosmiques, donc un indicateur de l'activité solaire)

sont extrêmement bien corrélées avec l'oxygène 18 (indicateur de

température). Le graphique du bas montre un intervalle de temps

particulièrement bien résolu de 8 350 à 7 900 ans BP.

Le graphique ci-dessus résume les données obtenues à

partir d'une stalagmite d'une grotte à Oman, comme indiqué dans l'article,

Neff, U., et al. 2001.

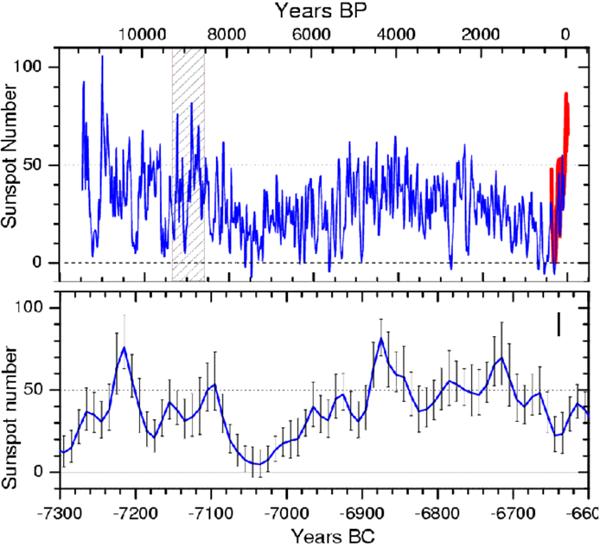

Une équipe de chercheurs dirigée par des scientifiques de

l'Institut Max Planck pour la recherche sur le système solaire a analysé les

isotopes radioactifs dans les arbres et a découvert que le Soleil a été plus

actif dans la dernière moitié du 20 e siècle qu'à n'importe quel moment au

cours des 8 000 derniers années. Cette étude a montré que l'épisode actuel

de forte activité solaire depuis environ 1940 est unique au cours des 8000

dernières années. Voir un communiqué de presse ici . Un graphique de l'étude est

ci-dessous. Le graphique du bas est un détail de la période ombrée du

graphique du haut de 9300 à 8600 ans avant le présent.

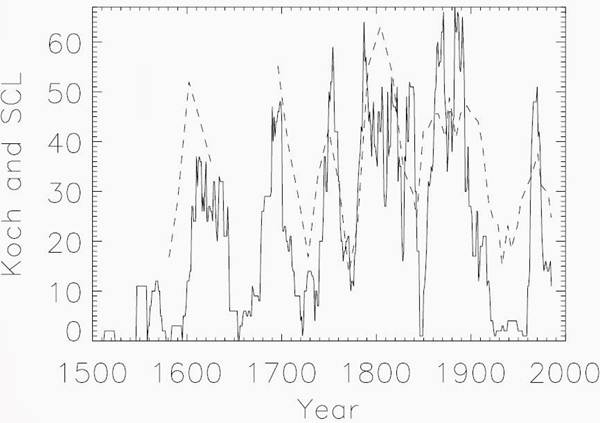

Une étude publiée par l'Institut météorologique danois

compare l'indice de glace de Koch, qui décrit la quantité de glace observée

depuis l'Islande, entre 1150 et 1983 après JC, à la durée du cycle solaire, qui

est une mesure de l'activité solaire. L'étude révèle qu'"une

corrélation étroite (R = 0,67) de haute signification (probabilité de

0,5 % d'occurrence fortuite) est trouvée entre les deux modèles, suggérant

un lien entre l'activité solaire et le climat de l'océan Arctique".

Source .

Tim Patterson, un conseiller du FoSS,

a étudié les enregistrements climatiques à haute résolution de l'Holocène des

fjords et des lacs côtiers de la Colombie-Britannique et a démontré un lien

entre la température et les cycles solaires.

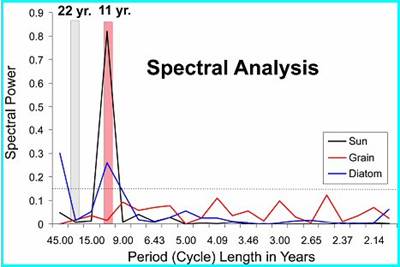

L'analyse spectrale présentée ici provient de carottes

de sédiments obtenues à Effingham Inlet,

île de Vancouver, Colombie-Britannique. Les laminations déposées

annuellement du noyau sont liées aux conditions climatiques

changeantes. L'analyse montre une forte corrélation avec le cycle des

taches solaires de 11 ans.

Voir ici

pour un diaporama powerpoint de Tim Patterson.

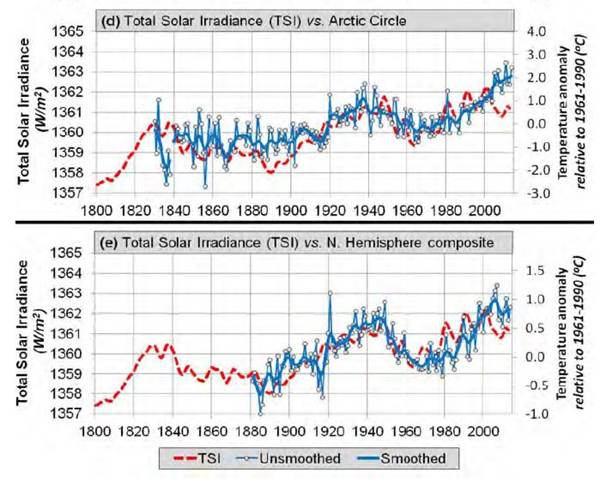

Un article de Soon et

al 2015 intitulé "Réévaluer le rôle de la variabilité solaire sur les

tendances de la température de l'hémisphère nord depuis le 19e siècle"

dans la section 5 compare une reconstruction mise à jour de l'irradiance

solaire totale de Hoyt & Schatten

aux composites de température de l'hémisphère arctique et nord qui sont basés

sur des données de température essentiellement rurales pour éliminer les effets

du développement urbain. L'accord général entre les tendances de la

température et de l'activité solaire est frappant. Le graphique ci-dessous

montre une corrélation de R2 = 0,48, ce qui implique que la variabilité solaire

a été l'influence dominante sur les tendances de température de l'hémisphère

nord depuis au moins 1881.

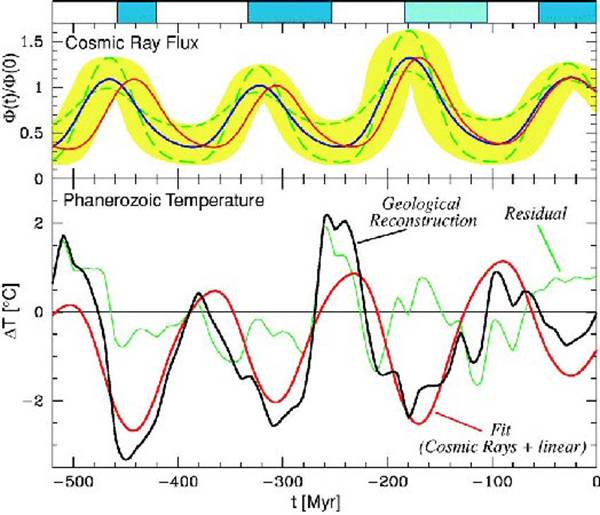

N. Shaviv et J. Veiser utilisant des thermomètres à coquillage montrent une

forte corrélation entre la température et le flux de rayons cosmiques au cours

des 520 derniers millions d'années.

Flux de rayons cosmiques et variation de

température tropicale au cours des 520 millions d'années du Phanérozoïque

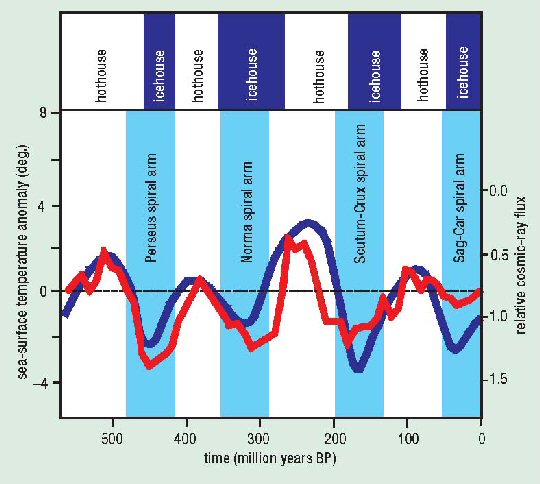

Les courbes supérieures décrivent le flux de rayons

cosmiques (CRF) en utilisant les données d'âge d'exposition aux météorites de

fer. La ligne bleue représente le CRF nominal, tandis que l'ombrage jaune

délimite la plage d'erreur autorisée. Les deux courbes en pointillés sont

des reconstructions CRF supplémentaires qui s'inscrivent dans la plage

acceptable. La courbe rouge décrit la reconstruction nominale du CRF après

que sa période a été affinée pour s'adapter au mieux à l'anomalie de température

des basses latitudes. La courbe noire du bas représente le changement de

température lissé dérivé des coquilles calcitiques au

cours du Phanérozoïque. La ligne rouge est le modèle de température prévu

pour la courbe rouge ci-dessus. La ligne verte est le résiduel. Les

barres bleues supérieures indiquent les périodes glaciaires.

Un article de Nicola Scafetta, mai 2012, intitulé "Un ensemble de

fréquences partagées entre les enregistrements historiques d'aurores des

latitudes moyennes et la température de surface mondiale" compare les

enregistrements historiques des aurores des latitudes moyennes de 1700 aux

enregistrements de température de surface. Il montre que les

enregistrements d'aurores partagent les mêmes fréquences d'oscillation

évidentes dans les enregistrements de température et dans plusieurs

enregistrements planétaires et solaires. L'auteur soutient que les

enregistrements d'aurores révèlent un lien physique entre le changement

climatique et les oscillations astronomiques.

Le résumé indique :

"En particulier, un grand cycle de

quasi-60 ans est tout à fait évident depuis 1650 dans tous les enregistrements

climatiques et astronomiques ici étudiés ... L'existence d'une modulation cyclique naturelle de 60 ans

de la température de surface globale induite par des mécanismes astronomiques,

par le seul, impliquerait qu'au moins 60 à 70% du réchauffement observé depuis

1970 est d'origine naturelle. De plus, le climat pourrait rester à peu

près stable au cours des prochaines décennies car le cycle de 60 ans est entré

dans sa phase de refroidissement."

Plus d'analyses sont présentées par Scarfetta dans sa présentation de 2011 "Les

oscillations héliosphériques et leur implication pour

les oscillations climatiques et les prévisions climatiques" à

la 3e

Conférence de Santa Fe sur le changement climatique mondial et régional .

Un article publié par Moffa-Sánchez et

al dans Nature Geoscience , mars 2014, intitulé "Solar

Forcing of North Atlantic Surface Temperature and Salinity Over the Past Millennium" a révélé que

l'activité solaire est bien corrélée avec les températures de l'Atlantique

Nord.

Le résumé indique :

"Il y a eu plusieurs fluctuations à

l'échelle centennale du climat et de l'océanographie de la région de

l'Atlantique Nord au cours des 1 000 dernières années, y compris une période de

refroidissement relatif d'environ 1450 à 1850 après JC connue sous le nom de

petit âge glaciaire. Ces variations peuvent être liées à des changements dans

l'irradiance solaire, amplifiée par les rétroactions, y compris la circulation

méridienne de retournement de l'Atlantique. ... une faible irradiance solaire

favorise le développement d'événements de blocage atmosphérique fréquents et

persistants, dans lesquels un système anticyclonique quasi stationnaire dans

l'est de l'Atlantique Nord modifie le flux des vents d'ouest. Nous concluons

que ce processus pourrait avoir contribué aux hivers froids consécutifs

documentés en Europe pendant le petit âge glaciaire.

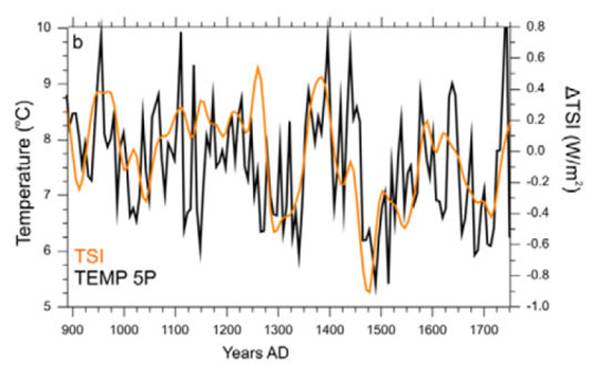

Le graphique ci-dessous, adapté de la figure 2,

présente l'enregistrement de température lissé en trois points RAPiD-17-5P en

noir. Au-dessus se trouve l'irradiance solaire totale (ΔTSI) qui a

été décalée avec un décalage de 12,4 ans. Cela montre clairement une forte

corrélation entre la température et la TSI.

Un examen plus approfondi du travail de Moffa-Sánchez est fourni à THE

HOCKEY SCHTICK .

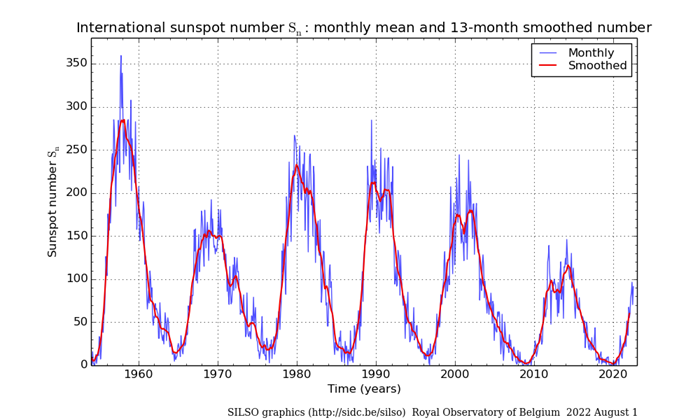

Le graphique du nombre de taches solaires de l'indice

des taches solaires et des observations solaires à long terme (SILSO) montrant

six cycles est présenté ci-dessous. Les données proviennent de

l'Observatoire Royal de Bruxelles. Le cycle des taches solaires 24 a un

nombre maximum de taches solaires lissé d'environ 115 en 2014.

Le nombre moyen mensuel de taches solaires et la

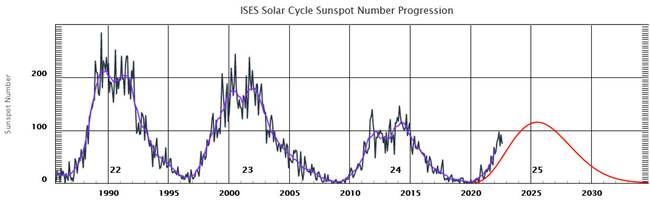

moyenne centrée sur 13 mois sont affichés. Les données sont ici . L'image du cycle solaire de

la NOAA ci-dessous provient d' ici .

Un nouveau modèle du soleil a produit des prédictions

d'une précision sans précédent des cycles solaires variables du soleil. Le

modèle utilise deux dynamos solaires, une près de la surface solaire et une

plus en profondeur dans la zone de convection. Le modèle a été décrit dans

un article de Shepherd et al 2014 ici et décrit ici . Le modèle prédit que

l'activité solaire passera de l'activité du cycle 24 de 60 % au cours des

années 2030 aux conditions observées pour la dernière fois au cours de la «

mini ère glaciaire » qui a commencé en 1645.

Soleil et rayons cosmiques

Au cours du 20 e siècle, le Soleil a continué à se

réchauffer et a peut-être contribué directement à un tiers du réchauffement au

cours des cent dernières années. La variation de la production solaire est

trop faible pour expliquer directement la majeure partie du réchauffement

observé. Cependant,

la connexion Soleil-Rayon Cosmique fournit un mécanisme d'amplification par

lequel un petit changement dans l'irradiance solaire aura un effet important

sur le climat.

Un article de H. Svensmark et E. Friis-Christensen du Centre de recherche sur le soleil et

le climat du Centre spatial national danois à Copenhague a montré que les

rayons cosmiques sont fortement corrélés à la formation de nuages

bas. Les changements d'intensité des rayons cosmiques

galactiques modifient la nébulosité de la Terre.

Une expérience en 2005 montre l'effet des rayons cosmiques dans

une chambre de réaction contenant de l'air et des traces de produits chimiques

trouvés au-dessus des océans. Les électrons libérés dans l'air par les

rayons cosmiques agissent comme un catalyseur dans la fabrication des

aérosols. Ils accélèrent considérablement la formation d'amas stables et ultra-petits de molécules d'acide sulfurique et d'eau, qui

sont la pierre angulaire des noyaux de condensation des nuages.

Des scientifiques danois ont rapporté en mai 2011 qu'ils avaient

réussi pour la première fois à observer directement que les particules chargées

électriquement venant de l'espace et frappant l'atmosphère à grande vitesse

contribuent à créer les aérosols qui sont les conditions préalables à la

formation des nuages. Dans

une chambre climatique de l'Université d'Aarhus, les scientifiques ont créé des

conditions similaires à l'atmosphère à la hauteur où se forment les nuages

bas. Cette atmosphère artificielle a été irradiée avec des

électrons rapides du plus grand accélérateur de particules ASTRID

Danemark. Les expériences montrent que l'augmentation du rayonnement des

rayons cosmiques conduit à plus d'aérosols. Dans l'atmosphère, ces

aérosols se transforment en véritables noyaux nuageux au fil des heures ou des

jours. La vapeur d'eau se concentre sur les noyaux formant de petites

gouttelettes nuageuses. Voir le papier ici .

Une équipe de 63 scientifiques a publié en août 2011 les résultats

d'une expérience beaucoup plus sophistiquée qui a étudié les effets des rayons

cosmiques sur la formation des nuages. L'expérience CLOUD (Cosmics Leaving OUtdoor Droplets) au CERN (Organisation européenne pour la

recherche nucléaire) à Genève montre les grands effets des pions d'un

accélérateur, qui simulent les rayons cosmiques et ionisent l'air dans la

chambre expérimentale. L'expérience

CLOUD est le test le plus rigoureux de l'hypothèse des rayons cosmiques jamais

conçu. Les expériences montrent que les rayons cosmiques augmentent

fortement le taux de formation des aérosols jusqu'à dix fois, et confirment les

résultats antérieurs de l'expérience danoise. Les aérosols peuvent se

transformer en noyaux de condensation nuageuse sur lesquels se forment des

gouttelettes nuageuses. Voir le communiqué de presse du

CERN ici .

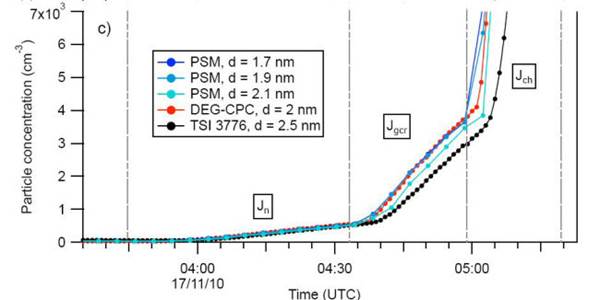

Le graphique

ci-dessous montre la croissance de la concentration

des particules d'aérosol dans la chambre CLOUD. Lors d'une expérience

expérimentale au CERN, à partir de 03h45, la lumière ultraviolette a commencé à

produire des molécules d'acide sulfurique dans la chambre, tandis qu'un champ

électrique puissant nettoyait l'air des ions. Dès que le champ électrique

a été éteint à 04h33, les rayons cosmiques naturels pleuvant à travers le toit

ont contribué à la formation d'amas à un rythme plus élevé. Lorsque CLOUD

a simulé des rayons cosmiques plus forts avec un faisceau de particules de

pions chargés commençant à 4:58, le taux de production

d'amas est devenu encore plus rapide. Les différentes couleurs

correspondent à des amas de différents diamètres (en nanomètres) enregistrés

par divers instruments. Le plus grand (noir) a mis plus de temps à pousser

que le plus petit (bleu).

Les éjections de masse coronale du soleil provoquent

une forte diminution du nombre de rayons cosmiques, appelée diminution de Forbush. Ces diminutions dramatiques et à court terme

des rayons cosmiques peuvent être utilisées pour confirmer les effets des

rayons cosmiques sur les nuages. Les nuages de plasma

magnétique provenant des éjections de masse coronale solaire fournissent un

bouclier temporaire contre les rayons cosmiques galactiques.

Une étude de Svensmark et al en 2009

montre que la diminution des rayons cosmiques a un effet important sur la

quantité d'aérosols, la couverture nuageuse et la teneur en eau liquide des

nuages. Les auteurs concluent "De l'activité solaire à l'ionisation

des rayons cosmiques en passant par les aérosols et les nuages

d'eau liquide, une chaîne causale semble fonctionner à l'échelle

mondiale."

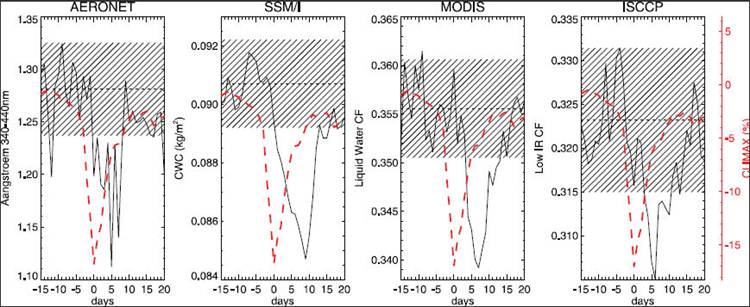

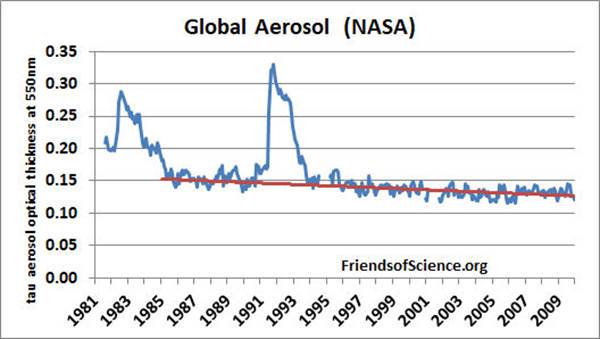

La figure ci-dessous montre l'évolution des particules fines

d'aérosols dans la basse atmosphère (AERONET), de la teneur en eau des nuages

(SSM/I), de la fraction nuageuse dans l'eau liquide (MODIS) et

des nuages détectés à faible IR (ISCCP), en moyenne pour les 5

plus forts Forbush diminue dans la période

1987-2007. La ligne pointillée rouge montre le changement moyen en

pourcentage du nombre de rayons cosmiques. Le nombre d'aérosols le plus

bas se produit 5 jours après le minimum de Forbush,

et le minimum de teneur en eau du nuage se produit 4 jours plus tard. La

réponse de la teneur en eau des nuages pour les événements plus

importants est d'environ 7 %.

Les lignes horizontales brisées indiquent la moyenne des 15

premiers jours avant le minimum de Forbush de chacun

des quatre ensembles de données.

Source .

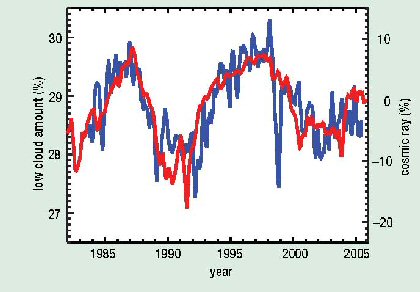

Les données du projet international de climatologie des nuages

par satellite et de la station de rayons cosmiques de Huancayo

montrent une corrélation remarquable entre les nuages bas (en

dessous de 3 km) et les rayons cosmiques. Il y a plus qu'assez de rayons cosmiques à haute

altitude, de sorte que les changements dans les rayons cosmiques n'affectent

pas les nuages élevés. Mais moins de rayons

cosmiques pénètrent dans les nuages inférieurs, ils sont donc

sensibles aux changements des rayons cosmiques.

Rayons cosmiques et

nuages bas

La ligne bleue montre les variations de la couverture

nuageuse mondiale recueillies par l'International Satellite Cloud Climatology Project. La ligne rouge est

l'enregistrement des variations mensuelles du nombre de rayons cosmiques à la

station Huancayo.

Les nuages

bas couvrent plus d'un quart de la surface de la Terre et

exercent un fort effet de refroidissement sur la surface. Un changement de

2 % des nuages bas au cours d'un cycle solaire modifiera l'apport

de chaleur à la surface de la Terre de 1,2 watts par mètre carré (W/m2). Cela

se compare au réchauffement total de 1,4 W/m2 cité

par le GIEC au

20 e siècle. (Le GIEC ne reconnaît

pas l'effet du soleil et des rayons cosmiques et attribue le réchauffement au

CO2.)

Le flux de rayons cosmiques peut être déterminé à partir

d'isotopes radioactifs tels que le béryllium-10 ou le champ magnétique coronal

ouvert du Soleil. Les deux proxies de rayons

cosmiques indépendants confirment qu'il y a eu une réduction spectaculaire du

flux de rayons cosmiques au cours du 20 e siècle alors que le Soleil a gagné

en intensité et que le champ magnétique coronal du Soleil a doublé en

intensité.

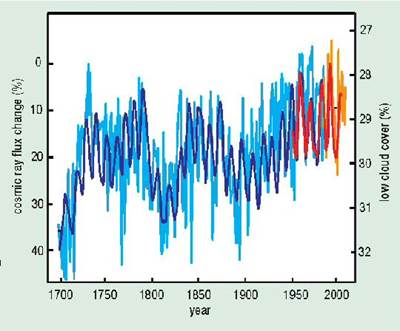

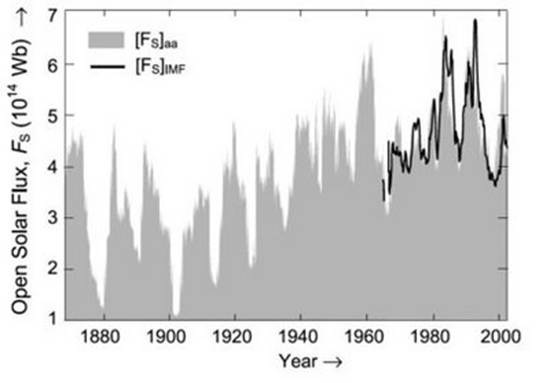

Flux de rayons cosmiques

depuis 1700

Les changements dans le flux de rayons cosmiques

galactiques depuis 1700 sont ici dérivés de deux proxys indépendants, 10 Be (bleu clair) et le flux coronal

solaire ouvert (bleu foncé) (Solanki et Fligge 1999). La faible quantité de nuages

(orange) est mise à l'échelle et normalisée par rapport aux

données d'observation des rayons cosmiques de Climax (rouge) pour la période

1953 à 2005 (seuil de 3 GeV). Les deux échelles

sont inversées pour correspondre à la hausse des températures. Notez que

le flux de rayons cosmiques élevé vers 1700 correspond à la fin du petit âge

glaciaire. A noter également l'augmentation du flux de rayons cosmiques

après 1780 au moment des Hivers de Dicken.

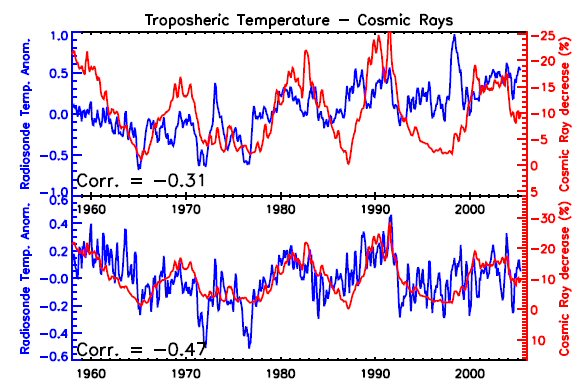

Le graphique ci-dessous

montre une corrélation entre le nombre de rayons cosmiques et les données de

radiosondage de la température globale de la troposphère. L'échelle des

rayons cosmiques est inversée pour correspondre à l'augmentation des températures. Une

activité solaire élevée correspond à un faible nombre de rayons cosmiques, à

une faible couverture nuageuse réduite et à des températures plus élevées. Le panneau supérieur montre les températures de la

troposphère en bleu et le nombre de rayons cosmiques en rouge. Le panneau

inférieur montre la correspondance obtenue en supprimant El Nino, l'oscillation

nord-atlantique, les aérosols volcaniques et une tendance linéaire de 0,14

degrés Celsius/décennie.

La corrélation négative entre le nombre de rayons

cosmiques et les températures de la troposphère est très forte, ce qui indique

que le Soleil est le principal moteur climatique. H. Svensmark

et E. Friis-Christensen ont publié le graphique

ci-dessus dans un article d'octobre 2007 en réponse à un article de M. Lockwood

et C. Frohlich, dans lequel ils soutiennent que le

lien historique entre le Soleil et le climat a pris fin il y a 20

ans. Cependant, l'article de Lockwood présentait plusieurs lacunes,

notamment le problème qu'il utilisait des données de température de surface

contaminées par l'effet d'îlot de chaleur urbain (voir ci-dessous). Ils ne

tiennent pas non plus compte du grand décalage temporel entre les changements

d'intensité solaire à long terme et la réponse de la température climatique.

Voir la réfutation de Svensmark et Gregory critique de

l'article de Lockwood.

Au cours du 20 e siècle, le Soleil a augmenté son

activité et son intensité d'irradiance, fournissant directement un certain

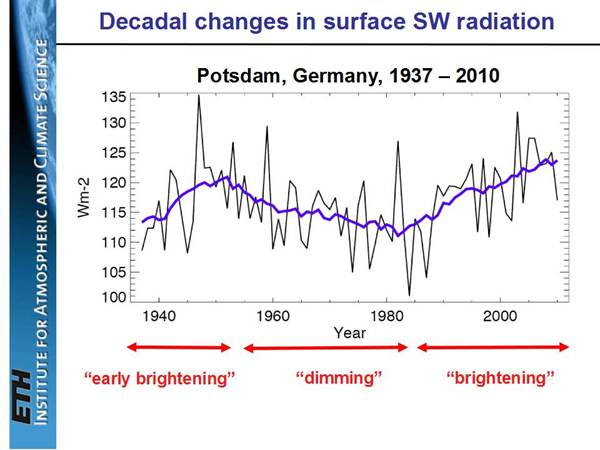

réchauffement. Le graphique ci-dessous à partir d' ici montre l'augmentation du flux

solaire pendant la majeure partie du XXe siècle.

Flux solaire ouvert

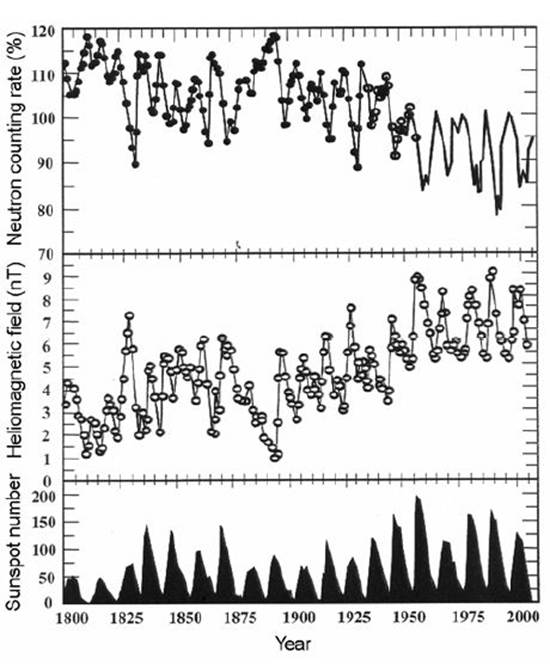

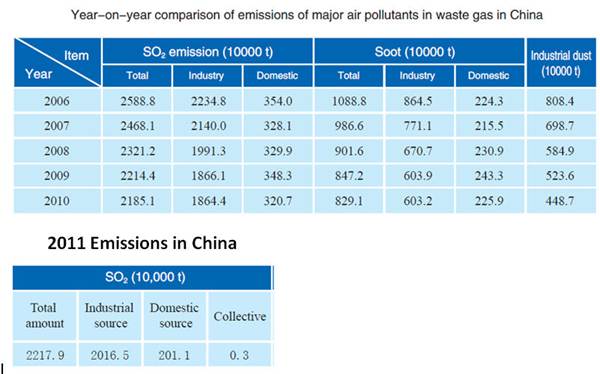

Le Dr UR Rao de

Bangalore, en Inde, montre que les rayons cosmiques galactiques, en utilisant

des mesures de 10 Be

dans la glace polaire profonde comme approximation, ont diminué de 9 % au cours

des 150 dernières années. La diminution des rayons cosmiques entraîne une

diminution de 2,0 % de la couverture nuageuse basse entraînant un forçage

radiatif de 1,1 W/m2,

soit environ 60 % de celui dû à l'augmentation du CO2 au

cours de la même période.

Source .

Dans le panneau supérieur montrant l'intensité des

rayons cosmiques, la ligne continue représente le taux de comptage estimé du

moniteur de neutrons Climax (1956-2000), les cercles vides indiquent les

mesures de la chambre d'ionisation pendant (1933-1956) et les cercles pleins

représentent l'intensité des rayons cosmiques dérivée de 10 Be (1801 -1932). 10 Be est un isotope radioactif à

longue durée de vie du béryllium produit par les rayons cosmiques. Le

panneau du milieu montre le champ hélio-magnétique proche de la Terre et le

panneau inférieur montre le nombre de taches solaires.

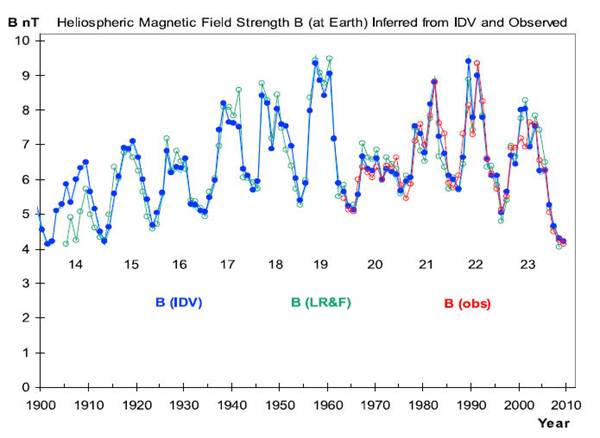

Une reconstruction de l'intensité du champ magnétique héliosphérique proche de la Terre de 1900 à 2009 à partir

d' ici par Svalgaard

et Cliver (2010) est présentée ci-dessous.

La courbe rouge représente les mesures directes par

satellite de l'intensité du champ magnétique héliosphérique

(HMF) proche de la Terre résultant du vent solaire. La courbe bleue est

l'indice de variabilité interdiurne (IDV) calculé à

partir des observations du champ géomagnétique une heure après

minuit. L'IDV est fortement corrélé avec le HMF proche de la

Terre. Les valeurs vertes sont des estimations de HMF par Lockwood et al

2009.

Lorsque le Soleil est actif, il a un plus grand nombre

de taches solaires et émet plus de vent solaire - un flux continu de particules

chargées à très grande vitesse. L'augmentation du vent solaire et du champ

magnétique repousse les rayons cosmiques qui, autrement, frapperaient

l'atmosphère terrestre, entraînant moins d'aérosols dans la basse atmosphère,

réduisant ainsi la formation de nuages bas. Les nuages

bas ont une réflectivité élevée et ont un fort effet de refroidissement

en renvoyant la lumière du soleil dans l'espace.

En résumé, le processus est :

Soleil plus actif → plus

de taches solaires → plus de vent solaire → moins de rayons

cosmiques → moins d'aérosols →

↪

moins de nuages bas → plus de lumière solaire à la surface

→ plus de réchauffement climatique.

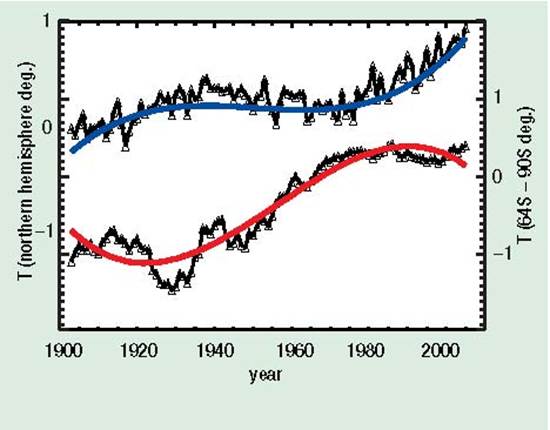

La théorie du CO2 le réchauffement implique que l'Arctique

et l'Antarctique devraient se réchauffer à peu près de la même manière, et les

régions polaires devraient se réchauffer plus que le reste de la Terre. Cependant, l'Antarctique ne

s'est pas réchauffé depuis 1975, ce qui est un gros problème pour

la théorie du CO2. La

glace recouvrant l'Antarctique a une réflectivité encore plus élevée que les

nuages bas, donc moins de nuages bas refroidissent

l'Antarctique, tandis que moins de nuages bas réchauffent le

reste de la planète. (La

calotte glaciaire du Groenland est beaucoup plus petite et n'est pas si

réfléchissante.) Cette

tendance de la température de l'Antarctique est une preuve solide que le

Soleil, et non le CO2,

est le principal moteur climatique.

Tendances des températures

en Antarctique et en Amérique du Nord

La courbe du haut est la température de surface

nord-américaine et la courbe du bas est la température de surface de

l'Antarctique (64 S - 90 S) au cours des 100 dernières années. Les données

antarctiques ont été moyennées sur 12 ans pour minimiser les fluctuations de

température. Les lignes bleues et rouges sont des ajustements polynomiaux

du quatrième ordre aux données. Les courbes sont décalées de 1 K pour plus de clarté; sinon

ils traverseraient et retraverseraient trois fois.

Le flux de rayons cosmiques n'est pas seulement influencé par le

vent solaire, il varie également avec la position du système solaire dans les

bras galactiques. Le système solaire traverse les bras de la galaxie de la

Voie lactée environ tous les 140 millions d'années. Lorsque le système

solaire est dans les bras galactiques, l'intensité des rayons cosmiques

augmente, à mesure que nous nous rapprochons de plus de supernovas qui émettent

de puissantes rafales de rayons cosmiques. Les variations du flux de rayons cosmiques dues au passage

du système solaire dans[MT12] les quatre

bras de la galaxie de la Voie lactée au cours des 550 derniers millions

d'années sont dix fois supérieures à celles provoquées par le Soleil. La corrélation entre les rayons

cosmiques et les températures sur 520 millions d'années par N. Shaviv et J. Veiser a été montrée

précédemment. Vous trouverez ci-dessous un graphique similaire basé sur

leur travail, mais avec les temps des croisements de bras galactiques indiqués.

Flux de rayons cosmiques

et changements de température avec les croisements de bras galactiques

Quatre passages des conditions de serre chaude à des

conditions de glacière froide au cours du Phanérozoïque sont représentés par

des variations de plusieurs degrés K des températures de surface de la mer

tropicale (courbe rouge). Ils correspondent à quatre rencontres avec des

bras spiraux de la Voie lactée et aux augmentations résultantes du flux de

rayons cosmiques (courbe bleue, échelle inversée). (D'après Shaviv et Veizer 2003) Les

changements de température sur cette plage de temps ne peuvent pas être expliqués

par la théorie

du CO2.

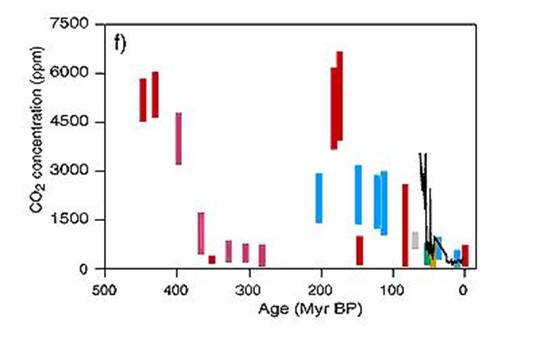

Concentrations de

CO 2 500 millions d'années

Le graphique montre la concentration de CO 2 au cours des 500 derniers millions

d'années. Le CO 2 n'est pas corrélé à la

température. Notez que lorsque les concentrations de CO 2 étaient plus de 10 fois les niveaux

actuels, il y a environ 175 millions d'années et il y a 440 millions d'années,

la Terre était dans deux périodes glaciaires très froides.

Sources :

1. Cosmoclimatologie : une nouvelle théorie émerge article de Henrik Svensmark, 2007

2. Moteur céleste

du climat phanérozoïque ? article de Shaviv et Veizer, 2003

3. National

Post de Tim Patterson, juillet 2003, examen de l'article de

Shaviv et Veizer

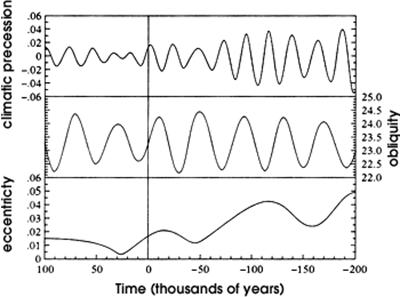

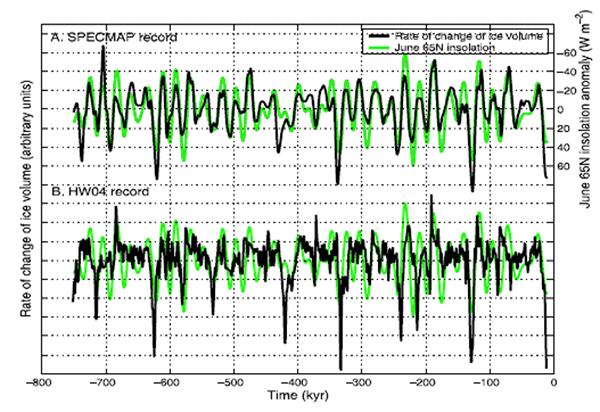

Cycles de Milankovitch

Les changements orbitaux Terre-Soleil sont les

principales causes du changement climatique à long terme. Au cours des 800

000 dernières années, huit périodes de glaciations se sont

produites. Chaque période glaciaire dure environ 100 000 ans avec des

périodes interglaciaires chaudes de 10 000 à 12 000 ans. Milutin Milankovitch (1879-1958)

a identifié trois grandes variables cycliques qui sont maintenant reconnues

comme les principales causes du changement climatique. La quantité de

rayonnement solaire atteignant la Terre dépend de la distance de la Terre au

Soleil et de l'angle d'incidence des rayons du Soleil sur la surface de la

Terre. L'inclinaison de l'axe de la Terre change sur un cycle de 40 000

ans, la précession de l'équinoxe change sur un cycle de 21 000 ans et

l'excentricité de l'orbite elliptique de la Terre change sur un cycle de 100

000 ans.

L'inclinaison de l'axe de la Terre (également connue sous le nom

d'obliquité de l'écliptique) passe de 22 à 24,5 degrés sur un cycle de 40 000

ans. Les extrêmes d'été à hiver sont plus grands lorsque l'inclinaison de

l'axe est plus grande. La précession de l'équinoxe fait référence à

l'oscillation de la Terre lorsqu'elle tourne sur son axe. Actuellement,

l'axe nord pointe vers l'étoile polaire, Polaris. Dans 13 000 ans, il

pointerait vers l'étoile Vega, puis reviendrait à Polaris dans 13 000 ans,

créant un cycle de 26 000 ans. Lorsque cela est combiné avec l'avancée du

périhélie (le point où la Terre est la plus proche de son orbite par rapport au

Soleil), cela produit un cycle de 21 000 ans. La variation de la forme

elliptique de l'orbite terrestre autour du soleil va d'un cercle presque exact

(excentricité = 0,0005) à une forme légèrement allongée (excentricité = 0,0607)

sur un cycle de 100 000 ans. La terre' L'excentricité de s varie

principalement en raison des interactions avec les champs gravitationnels

d'autres planètes. L'impact de la variation est un changement de la

quantité d'énergie solaire de l'approche la plus proche du Soleil (périhélie,